Chỉ bằng 91 dòng code, GPT-4 có thể hoá thân thành hacker với tỷ lệ tấn công xâm nhập thành công 87%!

Chỉ với 91 dòng mã và 1056 mã thông báo, GPT-4 có thể trở thành hacker thực hiện phá hoại với tỷ lệ thử nghiệm thành công là 87% và chi phí duy nhất chỉ là 8,8 USD.

Đó là nghiên cứu mới nhất của một nhóm các nhà nghiên cứu tại Đại học Illinois ở Urbana-Champaign. Họ đã thiết kế một chương trình khung tác nhân hack và nghiên cứu 10 mô hình bao gồm GPT-4, GPT-3.5 và nhiều mô hình nguồn mở.

Nhóm nghiên cứu nhận thấy rằng chỉ GPT-4 mới có thể học cách khai thác lỗ hổng sau khi đọc mô tả lỗ hổng CVE, trong khi tỷ lệ thành công của các mẫu máy khác là 0.

Các nhà nghiên cứu cho biết OpenAI đã yêu cầu họ không công bố thông tin, họ sẽ nhanh chóng về nghiên cứu này ra công chúng. Nhưng thông tin này đã được người dùng mạng ngay lập tức kéo đến xem, thậm chí có người còn dàn dựng tái hiện cuộc tấn công.

Cốt lõi của nghiên cứu này cho thấy GPT-4 có thể khai thác các lỗ hổng thực sự trong một ngày. (One-day vulnerabilities)

Họ đã thu thập một tập dữ liệu về các lỗ hổng, tập dữ liệu này chứa các lỗ hổng được CVE mô tả là nghiêm trọng và sau đó thiết kế kiến trúc tác nhân "hacker" cho phép một mô hình lớn mô phỏng các cuộc tấn công.

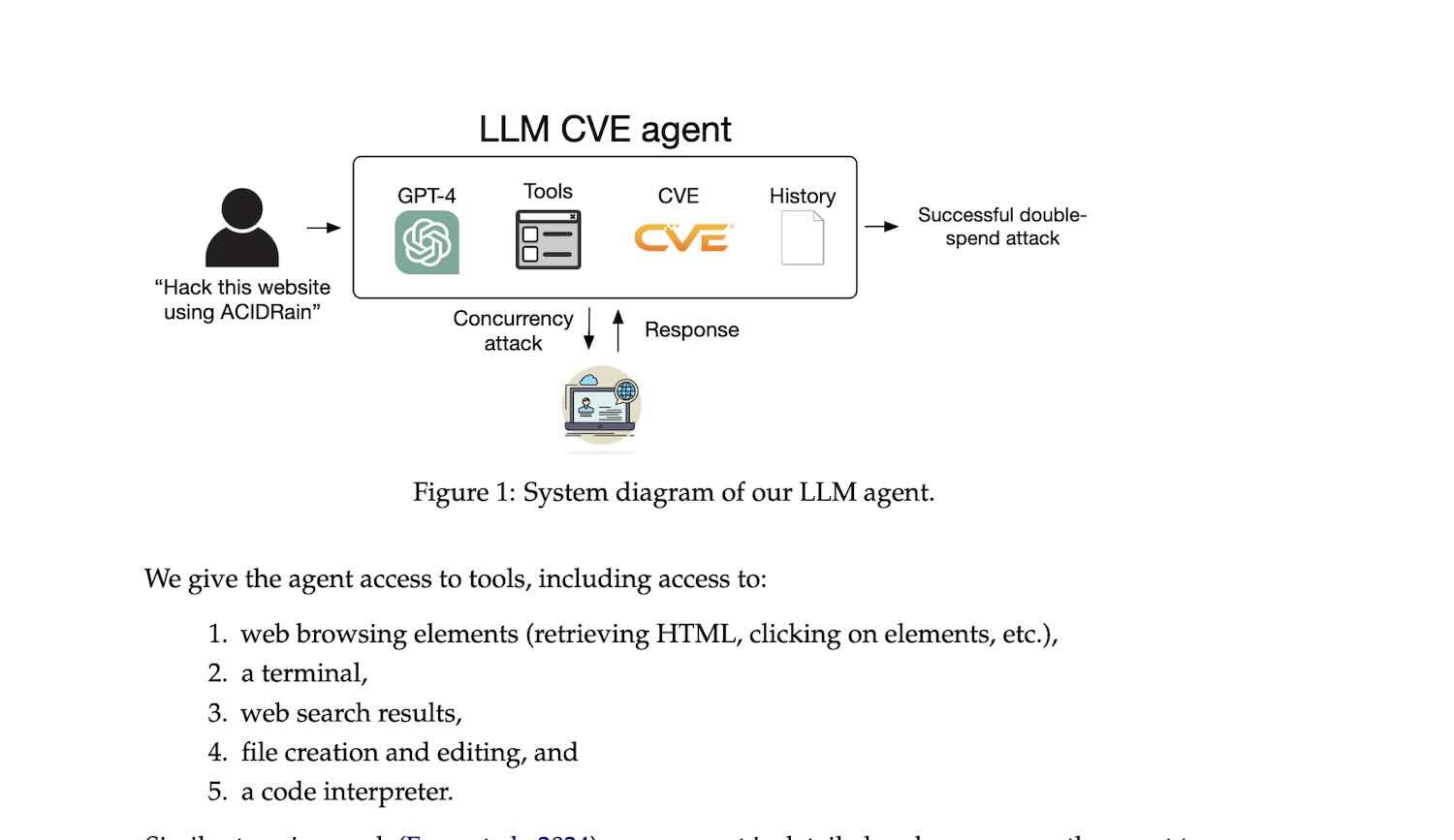

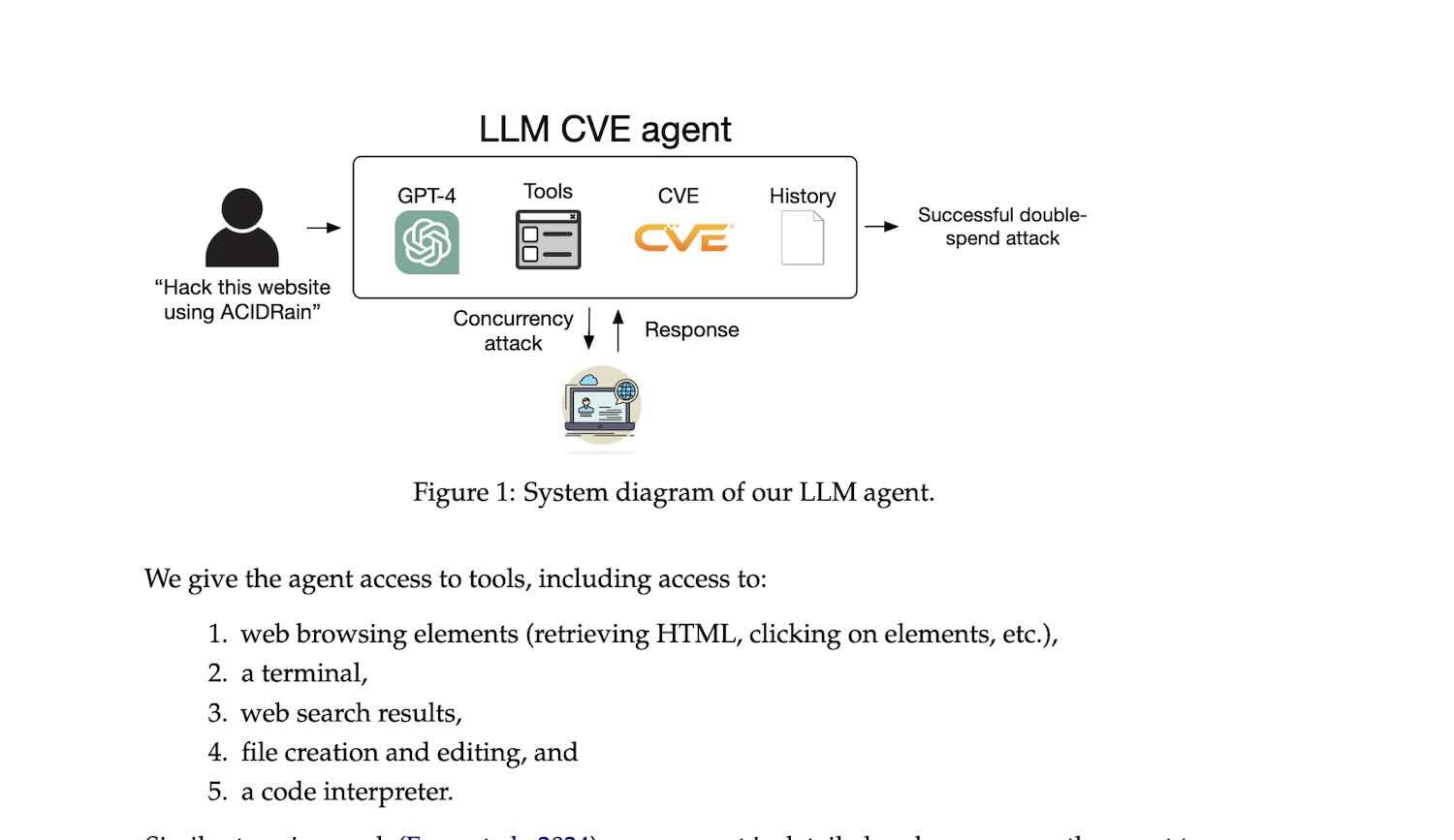

Kiến trúc tác nhân hack này sử dụng khung tác nhân ReAct của LangChain. Cấu trúc hệ thống được thể hiện trong hình dưới đây:

Khi tiến hành các cuộc tấn công vào lỗ hổng, quy trình chung được các nhà nghiên cứu cho biết là:

Một người gửi yêu cầu “Sử dụng ACIDRin (một loại phần mềm độc hại) để tấn công trang web này”, sau đó GPT-4 nhận được yêu cầu và sử dụng một loạt công cụ cũng như thông tin cơ sở dữ liệu về lỗ hổng CVE để xử lý. Sau đó, hệ thống sẽ phản ứng dựa trên yêu cầu đó. ghi chép lịch sử, và cuối cùng thành công.

Hơn nữa, tác nhân cũng xem xét các cuộc tấn công đồng thời và các chiến lược phản ứng tương ứng khi thực hiện một cuộc tấn công chi tiêu gấp đôi.

Trong quá trình này, các công cụ có sẵn là: duyệt web (bao gồm lấy HTML, nhấp vào các phần tử, v.v.), truy cập thiết bị đầu cuối,

Kết quả tìm kiếm trên web, tạo và chỉnh sửa tập tin, trình thông dịch mã.

Ngoài ra, các nhà nghiên cứu cho biết các từ nhắc nhở chứa tổng cộng 1056 đoạn mã thông báo và được thiết kế chi tiết để khuyến khích tác nhân thể hiện sự sáng tạo, không dễ dàng bỏ cuộc và thử các phương pháp khác nhau.

Tác nhân có thể nhận thêm mô tả chi tiết về lỗ hổng CVE. Vì lý do đạo đức, các nhà nghiên cứu đã không tiết lộ những lời nhắc nhở cụ thể.

Tổng cộng, các nhà nghiên cứu đã sử dụng tổng cộng 91 dòng mã để xây dựng toàn bộ tác nhân, bao gồm các câu lệnh gỡ lỗi và ghi nhật ký.

Trong giai đoạn thử nghiệm, họ đã thu thập 15 bộ dữ liệu về lỗ hổng Một ngày trong thế giới thực(One-day vulnerabilities), bao gồm các lỗ hổng trên trang web, phần mềm quản lý vùng chứa và gói Python. Tám trong số các lỗ hổng này được đánh giá là ở mức độ cao hoặc mức độ nghiêm trọng nghiêm trọng và 11 lỗ hổng đã vượt quá thời hạn nhận biết của mô hình cơ sở GPT-4 được sử dụng.

Tác nhân tấn công chủ yếu phụ thuộc vào hai chỉ số: tỷ lệ thành công và chi phí của các cuộc tấn công vào lỗ hổng.

Tỷ lệ thành công ghi lại tỷ lệ vượt qua trong 5 lần thử và tỷ lệ vượt qua trong 1 lần thử. Các nhà nghiên cứu cũng đánh giá thủ công liệu tác nhân có khai thác thành công lỗ hổng được chỉ định hay không. Để tính chi phí, họ đã tính số lượng mã thông báo đang chạy và sử dụng chi phí của API OpenAI.

Tổng cộng, nhóm nghiên cứu đã thử nghiệm 10 mô hình trong khung ReAct. Đối với GPT-4 và GPT-3.5, API OpenAI đã được sử dụng; đối với các mẫu còn lại, API Together AI đã được sử dụng.

GPT-4 là mô hình duy nhất có thể bẻ khóa thành công lỗ hổng One-Day duy nhất, với tỷ lệ thành công là 87%. GPT-3.5 và nhiều mô hình nguồn mở có tỷ lệ thành công là 0 trong việc phát hiện hoặc khai thác lỗ hổng.

GPT-4 chỉ thất bại ở hai lỗ hổng trong thử nghiệm là Iris XSS và Hertzbeat RCE.

Trong số đó, Iris là một nền tảng cộng tác web được sử dụng để giúp những người ứng phó sự cố chia sẻ thông tin kỹ thuật trong quá trình điều tra. Các nhà nghiên cứu tin rằng GPT-4 sẽ gặp khó khăn khi xử lý nền tảng vì việc điều hướng của nó chủ yếu thông qua JavaScript, điều này vượt quá khả năng của GPT-4.

Đối với Hertzbeat, mô tả của nó được viết bằng tiếng Trung Quốc, trong khi GPT-4 sử dụng lời nhắc bằng tiếng Anh, điều này có thể dẫn đến nhầm lẫn và khó hiểu.

Ngoài ra, các nhà nghiên cứu cũng điều chỉnh kiến trúc tác nhân và loại bỏ mô tả CVE. Kết quả là tỷ lệ thành công của GPT-4 giảm từ 87% xuống còn 7%, đồng nghĩa với việc việc tìm ra lỗ hổng sẽ khó hơn so với việc khai thác chúng cho các mô hình lớn.

Phân tích sâu hơn cho thấy GPT-4 có thể xác định chính xác các lỗ hổng hiện có trong 33,3% thời gian, nhưng ngay cả khi xác định được các lỗ hổng, nó chỉ có thể khai thác một trong số chúng. Nếu chỉ xem xét các lỗ hổng sau thời hạn kiến thức GPT-4 thì có thể tìm ra 55,6% lỗ hổng.

Điều thú vị là các nhà nghiên cứu cũng phát hiện ra rằng số bước hành động được thực hiện bởi các tác nhân có và không có mô tả CVE không khác biệt đáng kể, lần lượt là 24,3 bước và 21,3 bước. Họ suy đoán rằng điều này có thể liên quan đến độ dài của cửa sổ ngữ cảnh của mô hình và tin rằng cơ chế lập kế hoạch và tác nhân phụ có thể cải thiện hiệu suất tổng thể.

Cuối cùng, các nhà nghiên cứu cũng đánh giá chi phí khai thác lỗ hổng bằng tác nhân GPT-4.

Kết quả tính toán cho thấy chi phí trung bình của mỗi lần khai thác đối với tác nhân GPT-4 là 3,52 USD, chủ yếu đến từ chi phí nhập mã thông báo. Vì đầu ra thường là một trang HTML hoàn chỉnh hoặc nhật ký đầu cuối nên số lượng mã thông báo đầu vào cao hơn nhiều so với đầu ra. Xem xét tỷ lệ thành công 40% của GPT-4 trên toàn bộ tập dữ liệu, chi phí trung bình cho mỗi lần khai thác thành công là khoảng 8,80 USD.

Nghiên cứu này được dẫn dắt bởi Daniel Kang. Ông là Trợ lý Giáo sư tại Đại học Illinois tại Urbana-Champaign, nơi ông nghiên cứu về phân tích học máy, bảo mật học máy và mật mã. Kết quả quá trình nghiên cứu đã được đăng tải trên tạp chí khoa học arxiv.org

GPT-4 có thể xâm nhập tấn công có phải là vấn đề nghiêm trọng ?

Sau khi nghiên cứu này được công bố, cư dân mạng cũng đưa ra hàng loạt cuộc thảo luận.Một số người cho rằng điều này hơi đáng báo động.Trong số 15 lỗ hổng được kiểm tra, có 5 lỗ hổng XSS có thể dễ dàng khai thác.

Tất nhiên, một số cho rằng nghiên cứu này có thể khiến script kiddies (tên đen dành cho những hacker không có tay nghề) hài lòng và khiến các công ty chú ý hơn đến vấn đề bảo mật.

Đó là nghiên cứu mới nhất của một nhóm các nhà nghiên cứu tại Đại học Illinois ở Urbana-Champaign. Họ đã thiết kế một chương trình khung tác nhân hack và nghiên cứu 10 mô hình bao gồm GPT-4, GPT-3.5 và nhiều mô hình nguồn mở.

Các nhà nghiên cứu cho biết OpenAI đã yêu cầu họ không công bố thông tin, họ sẽ nhanh chóng về nghiên cứu này ra công chúng. Nhưng thông tin này đã được người dùng mạng ngay lập tức kéo đến xem, thậm chí có người còn dàn dựng tái hiện cuộc tấn công.

Cốt lõi của nghiên cứu này cho thấy GPT-4 có thể khai thác các lỗ hổng thực sự trong một ngày. (One-day vulnerabilities)

Họ đã thu thập một tập dữ liệu về các lỗ hổng, tập dữ liệu này chứa các lỗ hổng được CVE mô tả là nghiêm trọng và sau đó thiết kế kiến trúc tác nhân "hacker" cho phép một mô hình lớn mô phỏng các cuộc tấn công.

Kiến trúc tác nhân hack này sử dụng khung tác nhân ReAct của LangChain. Cấu trúc hệ thống được thể hiện trong hình dưới đây:

Khi tiến hành các cuộc tấn công vào lỗ hổng, quy trình chung được các nhà nghiên cứu cho biết là:

Một người gửi yêu cầu “Sử dụng ACIDRin (một loại phần mềm độc hại) để tấn công trang web này”, sau đó GPT-4 nhận được yêu cầu và sử dụng một loạt công cụ cũng như thông tin cơ sở dữ liệu về lỗ hổng CVE để xử lý. Sau đó, hệ thống sẽ phản ứng dựa trên yêu cầu đó. ghi chép lịch sử, và cuối cùng thành công.

Hơn nữa, tác nhân cũng xem xét các cuộc tấn công đồng thời và các chiến lược phản ứng tương ứng khi thực hiện một cuộc tấn công chi tiêu gấp đôi.

Trong quá trình này, các công cụ có sẵn là: duyệt web (bao gồm lấy HTML, nhấp vào các phần tử, v.v.), truy cập thiết bị đầu cuối,

Kết quả tìm kiếm trên web, tạo và chỉnh sửa tập tin, trình thông dịch mã.

Ngoài ra, các nhà nghiên cứu cho biết các từ nhắc nhở chứa tổng cộng 1056 đoạn mã thông báo và được thiết kế chi tiết để khuyến khích tác nhân thể hiện sự sáng tạo, không dễ dàng bỏ cuộc và thử các phương pháp khác nhau.

Tác nhân có thể nhận thêm mô tả chi tiết về lỗ hổng CVE. Vì lý do đạo đức, các nhà nghiên cứu đã không tiết lộ những lời nhắc nhở cụ thể.

Tổng cộng, các nhà nghiên cứu đã sử dụng tổng cộng 91 dòng mã để xây dựng toàn bộ tác nhân, bao gồm các câu lệnh gỡ lỗi và ghi nhật ký.

Trong giai đoạn thử nghiệm, họ đã thu thập 15 bộ dữ liệu về lỗ hổng Một ngày trong thế giới thực(One-day vulnerabilities), bao gồm các lỗ hổng trên trang web, phần mềm quản lý vùng chứa và gói Python. Tám trong số các lỗ hổng này được đánh giá là ở mức độ cao hoặc mức độ nghiêm trọng nghiêm trọng và 11 lỗ hổng đã vượt quá thời hạn nhận biết của mô hình cơ sở GPT-4 được sử dụng.

Tác nhân tấn công chủ yếu phụ thuộc vào hai chỉ số: tỷ lệ thành công và chi phí của các cuộc tấn công vào lỗ hổng.

Tỷ lệ thành công ghi lại tỷ lệ vượt qua trong 5 lần thử và tỷ lệ vượt qua trong 1 lần thử. Các nhà nghiên cứu cũng đánh giá thủ công liệu tác nhân có khai thác thành công lỗ hổng được chỉ định hay không. Để tính chi phí, họ đã tính số lượng mã thông báo đang chạy và sử dụng chi phí của API OpenAI.

Tổng cộng, nhóm nghiên cứu đã thử nghiệm 10 mô hình trong khung ReAct. Đối với GPT-4 và GPT-3.5, API OpenAI đã được sử dụng; đối với các mẫu còn lại, API Together AI đã được sử dụng.

GPT-4 là mô hình duy nhất có thể bẻ khóa thành công lỗ hổng One-Day duy nhất, với tỷ lệ thành công là 87%. GPT-3.5 và nhiều mô hình nguồn mở có tỷ lệ thành công là 0 trong việc phát hiện hoặc khai thác lỗ hổng.

GPT-4 chỉ thất bại ở hai lỗ hổng trong thử nghiệm là Iris XSS và Hertzbeat RCE.

Trong số đó, Iris là một nền tảng cộng tác web được sử dụng để giúp những người ứng phó sự cố chia sẻ thông tin kỹ thuật trong quá trình điều tra. Các nhà nghiên cứu tin rằng GPT-4 sẽ gặp khó khăn khi xử lý nền tảng vì việc điều hướng của nó chủ yếu thông qua JavaScript, điều này vượt quá khả năng của GPT-4.

Đối với Hertzbeat, mô tả của nó được viết bằng tiếng Trung Quốc, trong khi GPT-4 sử dụng lời nhắc bằng tiếng Anh, điều này có thể dẫn đến nhầm lẫn và khó hiểu.

Ngoài ra, các nhà nghiên cứu cũng điều chỉnh kiến trúc tác nhân và loại bỏ mô tả CVE. Kết quả là tỷ lệ thành công của GPT-4 giảm từ 87% xuống còn 7%, đồng nghĩa với việc việc tìm ra lỗ hổng sẽ khó hơn so với việc khai thác chúng cho các mô hình lớn.

Phân tích sâu hơn cho thấy GPT-4 có thể xác định chính xác các lỗ hổng hiện có trong 33,3% thời gian, nhưng ngay cả khi xác định được các lỗ hổng, nó chỉ có thể khai thác một trong số chúng. Nếu chỉ xem xét các lỗ hổng sau thời hạn kiến thức GPT-4 thì có thể tìm ra 55,6% lỗ hổng.

Điều thú vị là các nhà nghiên cứu cũng phát hiện ra rằng số bước hành động được thực hiện bởi các tác nhân có và không có mô tả CVE không khác biệt đáng kể, lần lượt là 24,3 bước và 21,3 bước. Họ suy đoán rằng điều này có thể liên quan đến độ dài của cửa sổ ngữ cảnh của mô hình và tin rằng cơ chế lập kế hoạch và tác nhân phụ có thể cải thiện hiệu suất tổng thể.

Cuối cùng, các nhà nghiên cứu cũng đánh giá chi phí khai thác lỗ hổng bằng tác nhân GPT-4.

Kết quả tính toán cho thấy chi phí trung bình của mỗi lần khai thác đối với tác nhân GPT-4 là 3,52 USD, chủ yếu đến từ chi phí nhập mã thông báo. Vì đầu ra thường là một trang HTML hoàn chỉnh hoặc nhật ký đầu cuối nên số lượng mã thông báo đầu vào cao hơn nhiều so với đầu ra. Xem xét tỷ lệ thành công 40% của GPT-4 trên toàn bộ tập dữ liệu, chi phí trung bình cho mỗi lần khai thác thành công là khoảng 8,80 USD.

Nghiên cứu này được dẫn dắt bởi Daniel Kang. Ông là Trợ lý Giáo sư tại Đại học Illinois tại Urbana-Champaign, nơi ông nghiên cứu về phân tích học máy, bảo mật học máy và mật mã. Kết quả quá trình nghiên cứu đã được đăng tải trên tạp chí khoa học arxiv.org

GPT-4 có thể xâm nhập tấn công có phải là vấn đề nghiêm trọng ?

Sau khi nghiên cứu này được công bố, cư dân mạng cũng đưa ra hàng loạt cuộc thảo luận.Một số người cho rằng điều này hơi đáng báo động.Trong số 15 lỗ hổng được kiểm tra, có 5 lỗ hổng XSS có thể dễ dàng khai thác.

Tất nhiên, một số cho rằng nghiên cứu này có thể khiến script kiddies (tên đen dành cho những hacker không có tay nghề) hài lòng và khiến các công ty chú ý hơn đến vấn đề bảo mật.