Meta SAM 2 AI mã nguồn mở thống nhất đầu tiên có thể phân đoạn các đối tượng trong hình ảnh và video theo thời gian thực

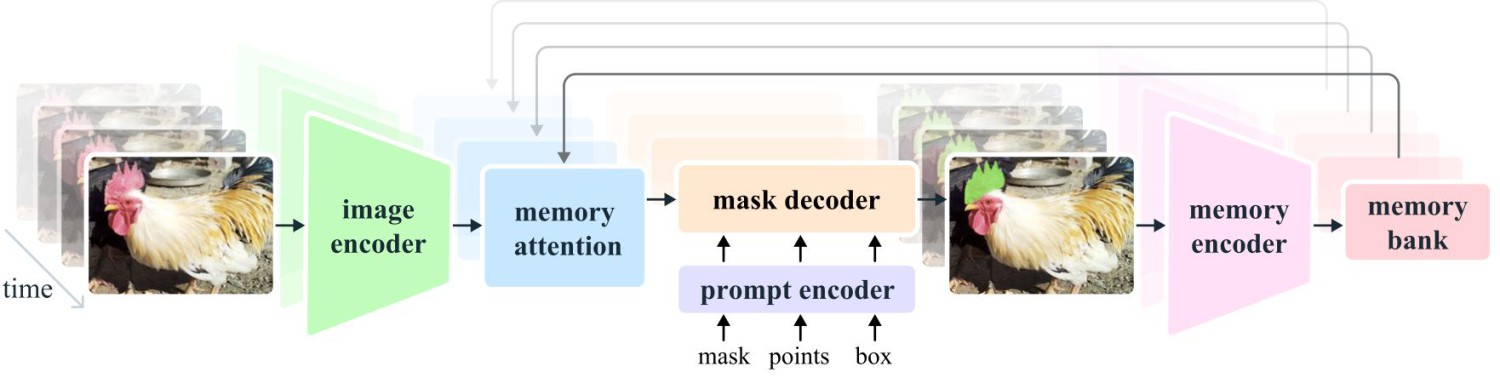

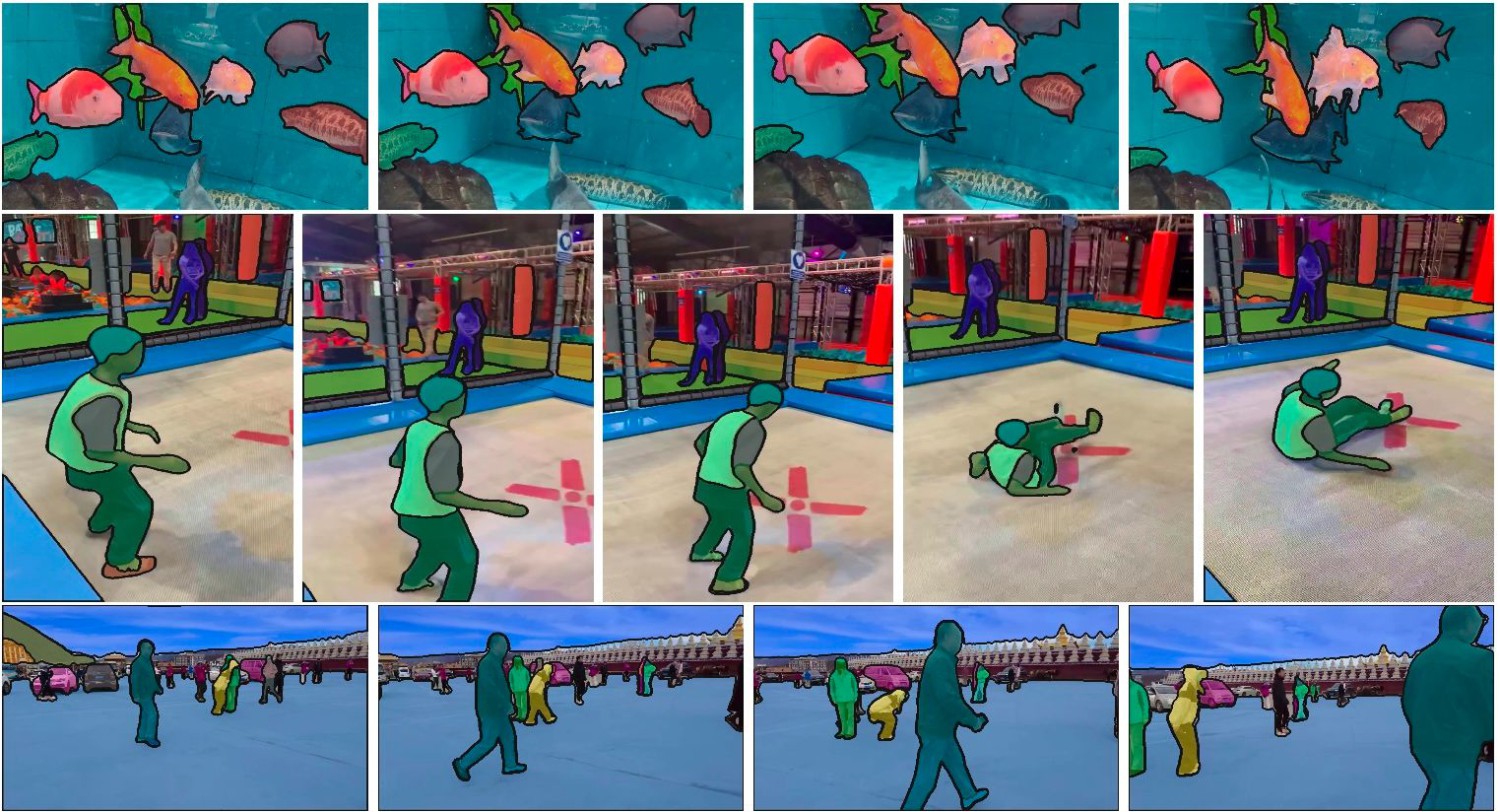

Vn-Z.vn Ngày 30 tháng 07 năm 2024, Meta đã phát hành Meta Segment Anything Model 2 (SAM2). SAM2 có thể phân đoạn bất kỳ mục tiêu nào, có khả năng theo dõi tất cả các khung hình trong một video theo thời gian thực - mở khóa khả năng chỉnh sửa video mới và cung cấp trải nghiệm mới trong thực tế hỗn hợp.

Hôm nay, Meta Corporation đã phát hành bài viết trên trang blog chính thức của mình giới thiệu mô hình Meta Segment Anything Model 2 (SAM 2) mới, mô hình đầu tiên hỗ trợ phân đoạn đối tượng trong video và hình ảnh.

Mã nguồn mở

Meta công bố sẽ phát hành SAM 2 theo giấy phép Apache 2.0, do đó bất kỳ ai cũng có thể sử dụng nó để xây dựng trải nghiệm của riêng mình.

Meta cũng sẽ chia sẻ tập dữ liệu SA-V được sử dụng để xây dựng SAM 2 theo giấy phép CC BY 4.0 và phát hành trải nghiệm demo dựa trên web, nơi mọi người có thể thử nghiệm phiên bản mô hình của Meta.

Phân đoạn đối tượng

Phân đoạn đối tượng (Object segmentation) là việc nhận diện các pixel trong hình ảnh tương ứng với đối tượng quan tâm, đây là một nhiệm vụ cơ bản trong lĩnh vực thị giác máy tính.

Được biết, Meta đã phát hành mô hình cơ bản SAM 1 vào năm 2023, mô hình này có thể phân đoạn các đối tượng trên hình ảnh. SAM 2 mới được phát hành có thể được sử dụng cho hình ảnh và video, đồng thời có thể đạt được khả năng phân đoạn đối tượng nhanh chóng, theo thời gian thực.

SAM 2 vượt trội hơn các khả năng trước đây về độ chính xác trong phân đoạn hình ảnh, có hiệu suất phân đoạn video tốt hơn so với các kết quả hiện có, đồng thời thời gian tương tác cần thiết giảm ba lần.

SAM 2 còn có thể phân đoạn bất kỳ đối tượng nào trong bất kỳ video hoặc hình ảnh nào (thường được gọi là khái quát hóa zero-shot), điều này có nghĩa là nó có thể được áp dụng cho các nội dung hình ảnh chưa từng thấy trước đây mà không cần phải điều chỉnh tùy chỉnh.

Bạn đọc có thể tham khảo thêm thông tin tại

github.com

github.com

ai.meta.com

ai.meta.com

about.fb.com

about.fb.com

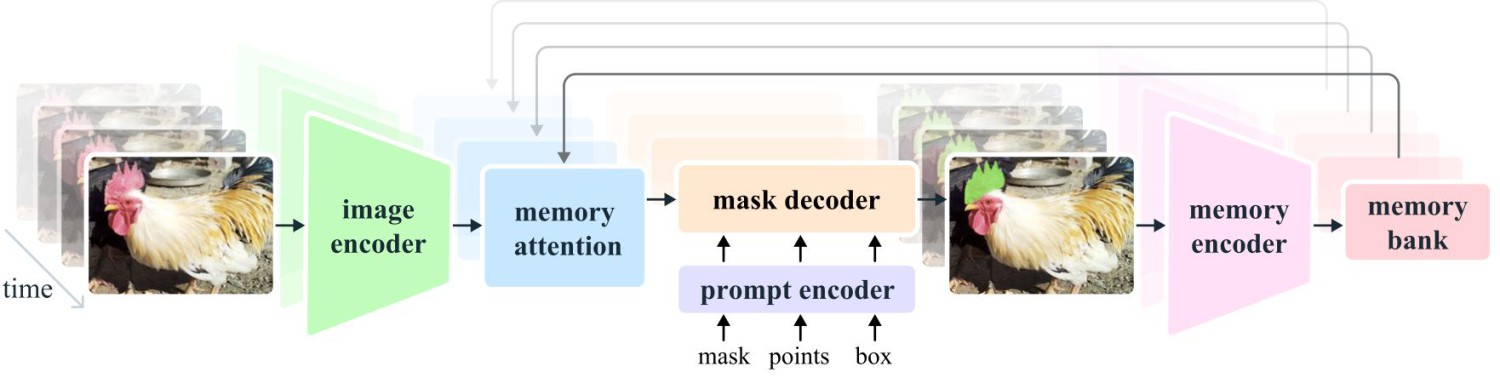

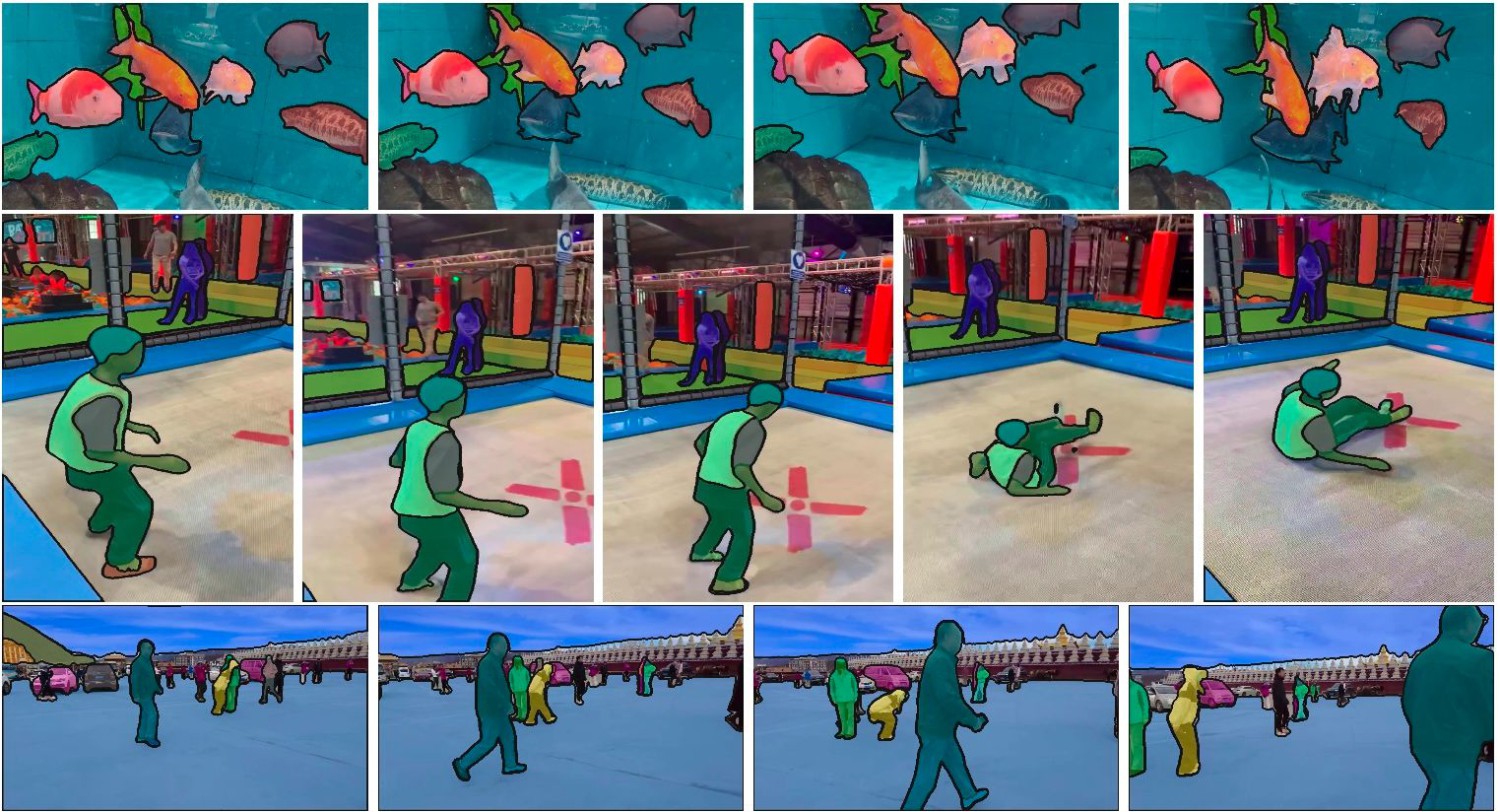

Hôm nay, Meta Corporation đã phát hành bài viết trên trang blog chính thức của mình giới thiệu mô hình Meta Segment Anything Model 2 (SAM 2) mới, mô hình đầu tiên hỗ trợ phân đoạn đối tượng trong video và hình ảnh.

Mã nguồn mở

Meta công bố sẽ phát hành SAM 2 theo giấy phép Apache 2.0, do đó bất kỳ ai cũng có thể sử dụng nó để xây dựng trải nghiệm của riêng mình.

Meta cũng sẽ chia sẻ tập dữ liệu SA-V được sử dụng để xây dựng SAM 2 theo giấy phép CC BY 4.0 và phát hành trải nghiệm demo dựa trên web, nơi mọi người có thể thử nghiệm phiên bản mô hình của Meta.

Phân đoạn đối tượng

Phân đoạn đối tượng (Object segmentation) là việc nhận diện các pixel trong hình ảnh tương ứng với đối tượng quan tâm, đây là một nhiệm vụ cơ bản trong lĩnh vực thị giác máy tính.

Được biết, Meta đã phát hành mô hình cơ bản SAM 1 vào năm 2023, mô hình này có thể phân đoạn các đối tượng trên hình ảnh. SAM 2 mới được phát hành có thể được sử dụng cho hình ảnh và video, đồng thời có thể đạt được khả năng phân đoạn đối tượng nhanh chóng, theo thời gian thực.

SAM 2 vượt trội hơn các khả năng trước đây về độ chính xác trong phân đoạn hình ảnh, có hiệu suất phân đoạn video tốt hơn so với các kết quả hiện có, đồng thời thời gian tương tác cần thiết giảm ba lần.

SAM 2 còn có thể phân đoạn bất kỳ đối tượng nào trong bất kỳ video hoặc hình ảnh nào (thường được gọi là khái quát hóa zero-shot), điều này có nghĩa là nó có thể được áp dụng cho các nội dung hình ảnh chưa từng thấy trước đây mà không cần phải điều chỉnh tùy chỉnh.

Bạn đọc có thể tham khảo thêm thông tin tại

GitHub - facebookresearch/sam2: The repository provides code for running inference with the Meta Segment Anything Model 2 (SAM 2), links for downloading the trained model checkpoints, and example notebooks that show how to use the model.

The repository provides code for running inference with the Meta Segment Anything Model 2 (SAM 2), links for downloading the trained model checkpoints, and example notebooks that show how to use th...

Introducing SAM 2: The next generation of Meta Segment Anything Model for videos and images

Today, we’re publicly releasing SAM 2, the first-ever unified model for segmenting anything in videos and images.

ai.meta.com

ai.meta.com

Our New AI Model Can Segment Anything – Even Video | Meta

We’re introducing Segment Anything Model 2, the first unified model that can identify which pixels belong to a target object in an image or video.

BÀI MỚI ĐANG THẢO LUẬN