Mặt trái của AI Deep fake, Deepnude bị phát hiện tiếp tục đánh cắp và tạo ra những bức ảnh không đứng đắn

(VN-Z.vn) Ngày 21 tháng 10 năm 2020, Mình nghe ở đâu đó có câu nói " Công nghệ là vô tội, thiện ác ở trong lòng người." Mặt trái của AI Deep fake đánh cắp "ảnh tự sướng và tạo ra những bức ảnh không đứng đắn. Bạn còn nhớ DeepNude "một cú nhấp chuột AI sẽ lột đồ" chứ? Vào tháng 6 năm 2019, phần mềm chuyên sâu này được phát hành trong vài giờ và nhanh chóng bị quá tải do có quá nhiều yêu cầu truy cập. Nguyên nhân là phần mềm này có thể cởi quần áo của phụ nữ chỉ bằng một cú nhấp chuột và tạo ra một số lượng lớn hình ảnh khiêu dâm.

Mới đây, theo điều tra, phần mềm tạo ảnh khiêu dâm này đã xuất hiện trở lại trong ứng dụng nhắn tin tức thời-Telegram. Phần mềm này đã phát hành công khai khoảng 104.852 hình ảnh khiêu dâm trên nền tảng TeleGram , nhiều dữ liệu gồm các hình ảnh được chia sẻ công khai. Quan trọng hơn, 70% những bức hình này đều là của những người phụ nữ có thật trên mạng xã hội, thậm chí là trẻ vị thành niên. Nói cách khác, những bức ảnh tự chụp hàng ngày được chia sẻ trên các phương tiện truyền thông xã hội như Facebook, Tiktok, .v.v.v có khả năng được sử dụng để tạo ra những bức ảnh không đứng đắn này.

DeepNude đang để mắt đến "những người bạn có thể biết"

Theo một cuộc điều tra này đến từ công ty an ninh mạng Sensity có trụ sở tại Amsterdam, trong chiến dịch "tình báo về mối đe dọa trực quan", đặc biệt là việc phổ biến các video giả . Cuộc điều tra của họ cho thấy tính đến cuối tháng 7, tất cả bảy kênh chính trên nền tảng Telegram đều đang sử dụng phần mềm DeepNude.

Phần mềm Deepnude thu hút 103.585 người dùng trên toàn thế giới, trong đó kênh có nhiều người dùng nhất là 45.615. Hầu hết những người dùng này tập trung ở Nga và các khu vực lân cận của Đông Âu. Có thể có ba lý do chính dẫn đến sự bùng nổ của phần mềm này.

Quá trình tạo ảnh nude rất dễ dàng chỉ bằng một cú nhấp chuột

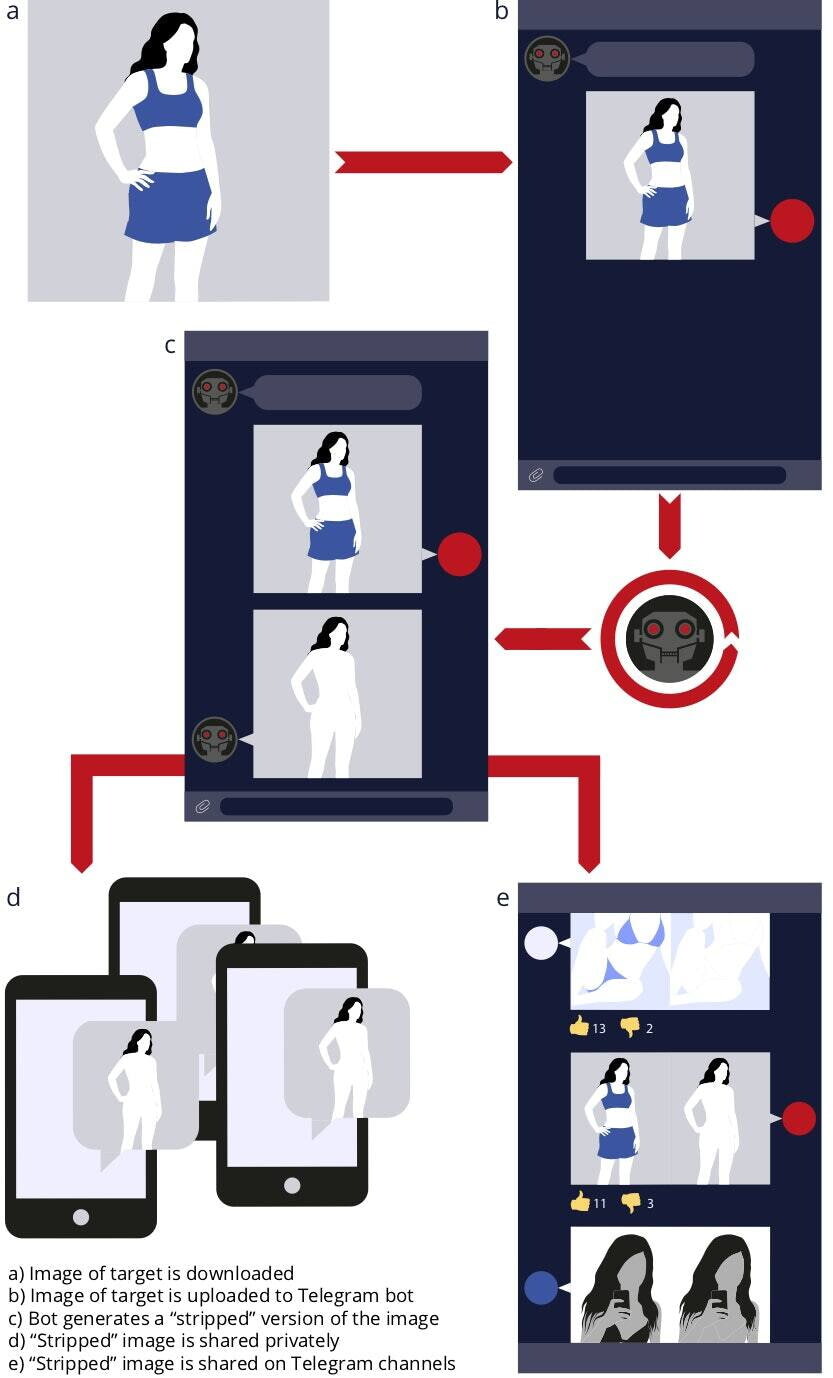

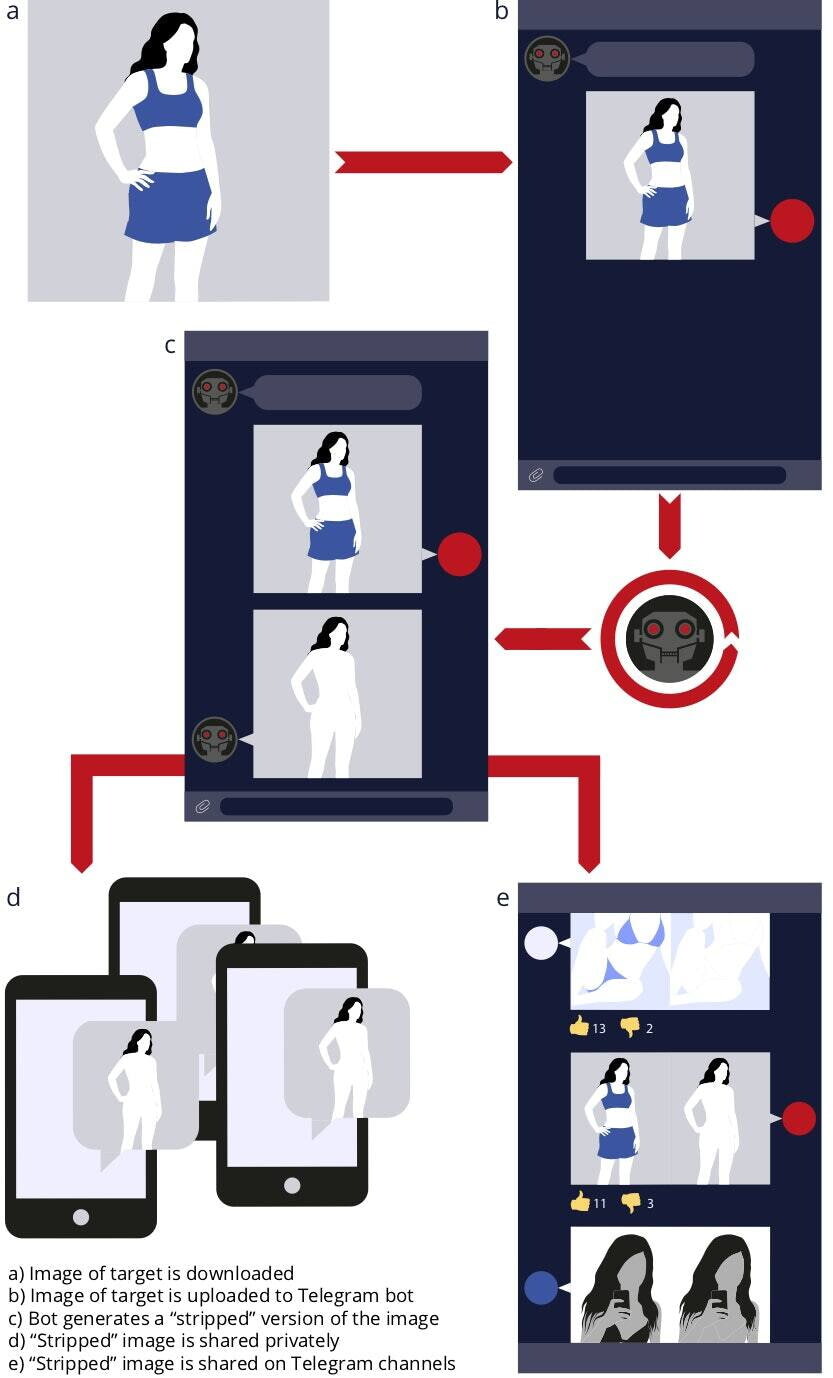

- Một là thao tác rất đơn giản, bạn chỉ cần một bức ảnh, sau khi tải lên phần mềm, một bức ảnh khỏa thân có thể tự động tạo ra trong vài giây mà không cần kiến thức kỹ thuật hay phần cứng hỗ trợ đặc biệt nào.

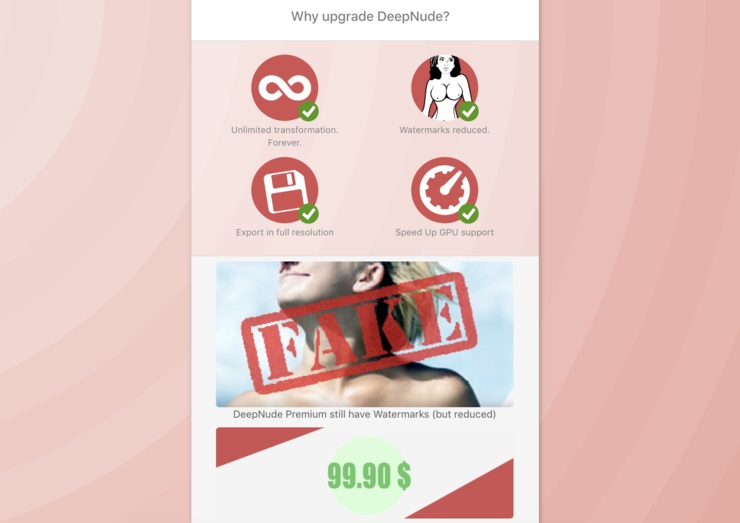

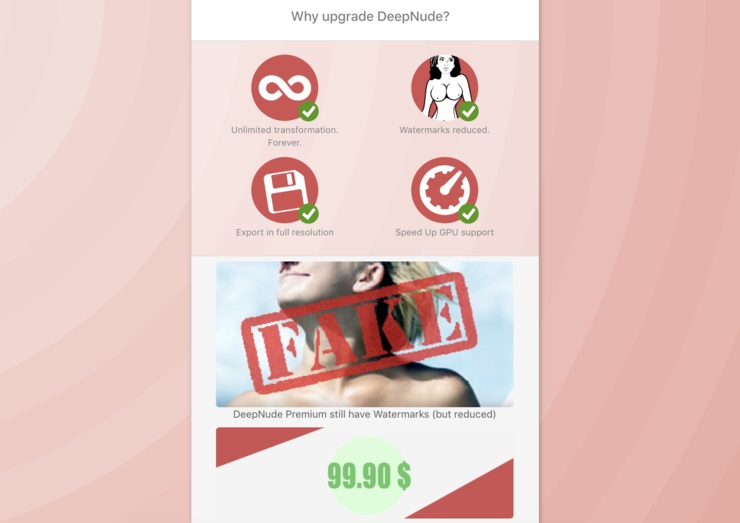

- Thứ hai là nó miễn phí cho tất cả mọi người. Tuy nhiên, nó cũng có mô hình tạo ra lợi nhuận. Những bức ảnh khỏa thân mà người dùng không trả tiền có được sẽ bị gắn nhãn hình mờ watermark hoặc chỉ bị lộ một phần. Người dùng có thể trả 1,28 đô la Mỹ để có được những bức ảnh không có hình mờ, nhưng sự cho phép chỉ giới hạn ở 100 bức ảnh trong bảy ngày.

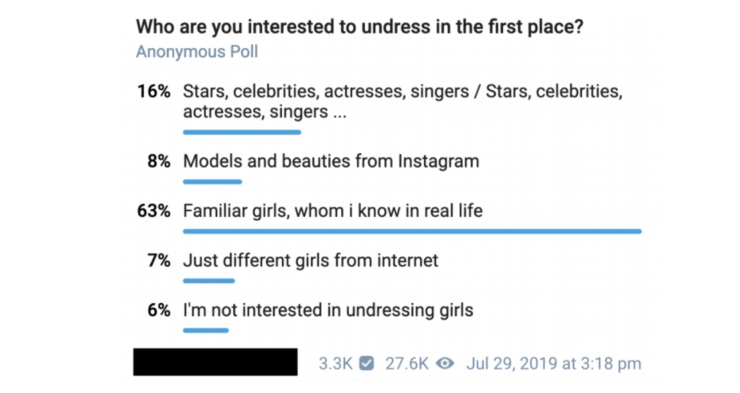

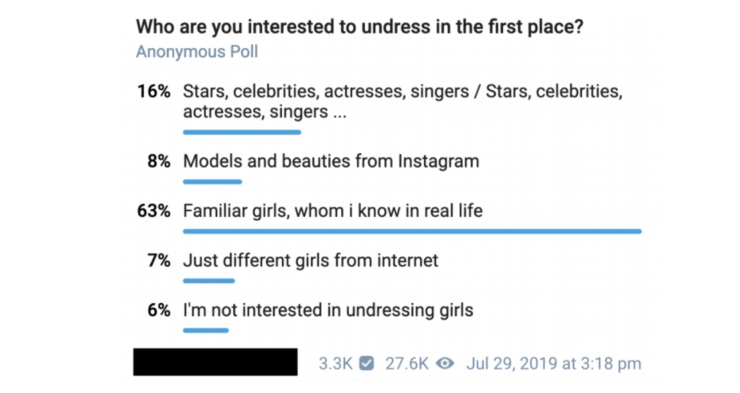

- Thứ ba là lấy ảnh khỏa thân của những người thân quen. Không có gì lạ khi Deepfake giả mạo các video khiêu dâm, chủ yếu nhắm vào những người nổi tiếng. Tuy nhiên, theo một cuộc khảo sát dư luận, phần lớn người dùng quan tâm đến "những người phụ nữ mà họ biết ngoài đời" hơn, chiếm 63%.

Với các lý do như vậy, bất kỳ người dùng nào của DeepNude cũng có thể tạo ảnh khỏa thân với bất kỳ ảnh nào. Theo dữ liệu công khai trên nền tảng TeleGram, nhiều phụ nữ trong ảnh là nhân viên văn phòng và sinh viên đại học. Những bức ảnh đều là ảnh tự chụp từ các nền tảng như TikTok, Instagram và Facebook. Một điểm cần lưu ý là phần mềm này chỉ nhằm và các bức ảnh về phụ nữ. Nếu bạn tải lên một bức ảnh nam hoặc bất kỳ bức ảnh vô tri vô giác nào khác, hệ thống sẽ tự động được thay thế bằng cơ thể của phụ nữ và được thay thế bởi các bộ phận tương ứng.

Theo nhóm trưởng Giorgio Patrini của Sensity cho biết hơn 680.000 phụ nữ đã bị làm giả ảnh khiêu dâm và tải lên các nền tảng truyền thông công cộng trong những trường hợp không xác định. Dữ liệu điều tra liên quan đã được tiết lộ cho công chúng, và các cơ quan thực thi pháp luật liên quan cũng đã mở một cuộc điều tra. Cho đến nay, Telegram vẫn chưa đưa ra câu trả lời công khai về lý do tại sao phần mềm khiêu dâm lại được phép xuất hiện trên nền tảng của họ.

Cũng trong các cuộc khảo sát của Sensity, ngoài Telegram, nền tảng mạng xã hội khác của Nga là VK cũng đã phát hiện ra DeepNude , thậm chí còn bắt đầu quảng cáo phần mềm này một cách công khai. Tuy nhiên, ngay sau khi sự việc lộ ra, người có trách nhiệm liên quan đã lập tức phản hồi và phủ nhận tuyên bố này. Đồng thời, ông nhấn mạnh : " VK không chấp nhận sự hiện diện của nội dung hoặc liên kết như vậy trên nền tảng và cũng sẽ ngăn cản cộng đồng phân phối chúng. Ngoài ra, các cộng đồng hoặc liên kết như vậy không được quảng cáo bằng công cụ quảng cáo VK , chúng tôi cũng tiến hành kiểm tra bổ sung và ngăn chặn nội dung không phù hợp xuất hiện."

Được biết Deepnude là phần mềm giả mạo khiêu dâm , mục đích ban đầu được tạo ra vì sự tò mò và niềm đam mê công nghệ. Vào ngày 27 tháng 6 năm 2019, phần mềm DeepNude được ra mắt công khai lần đầu tiên và ngay sau đó, hệ thống đã ngừng hoạt động do lưu lượng người dùng quá nhiều. Chỉ trong vài giờ, phần mềm sử dụng AI chỉ bằng một cú nhấp chuột là có thể biến ảnh thường thành ảnh nude của phụ nữ này đã gây náo động cả trong và ngoài nước.

Các cáo buộc "xâm phạm quyền riêng tư và phân biệt giới tính" liên tục xuất hiện trên các nền tảng mạng xã hội lớn như Twitter, Reddit , Facebook.v.v.v. Chuyên gia tiên phong về AI và máy học Andrew Ng đăng dòng tweet rằng DeepNude là "một trong những ứng dụng kinh tởm nhất của trí tuệ nhân tạo."

Sau khi nhận được nhiều phản ứng của cả thế giới , người đứng sau phát triển nó, Alberto (Alberto) đã công khai trả lời:

"Thế giới vẫn chưa sẵn sàng cho DeepNude!" "Tôi không phải là một người thích tìm hiểu (tò mò). Tôi là tín đồ của công nghệ." Anh nhấn mạnh: “Tôi không quan tâm đến ảnh khỏa thân và những thứ tương tự. Một số người không muốn sử dụng chúng, vì vậy họ chỉ muốn để người khác không sử dụng chúng. Điều này thật ngu ngốc. Việc chặn và kiểm duyệt kiến thức kỹ thuật không thể ngăn chặn sự phát tán và lây lan của nó. . "

Người ta hiểu rằng nguồn cảm hứng nghiên cứu và phát triển của Alberto đến từ kỹ thuật chụp X-quang trên tạp chí. Anh rất quan tâm đến công nghệ AI, khi phát hiện ra mạng GAN có thể chỉnh sửa ảnh từ ngày sang đêm, anh nhận ra rằng sử dụng GAN cũng có thể chuyển ảnh có quần áo thành ảnh không có quần áo. Vì tò mò mà DeepNude cuối cùng đã được phát triển.

DeepNud dựa trên một phần mềm "dịch ảnh sang ảnh" mã nguồn mở có tên "pix2pix", được phát hiện lần đầu tiên vào năm 2018 bởi các nhà nghiên cứu AI tại Đại học California, Berkeley. Công nghệ cốt lõi của nó là GAN, có thể tạo ra ảnh giả bằng cách xác định hình ảnh thực. Chẳng hạn như thay đổi ảnh phong cảnh từ ngày sang đêm hoặc từ đen trắng sang đủ màu.

Nhưng dù là vì tò mò hay vì muốn tìm hiểu sự phát triển công nghệ, phần mềm này quả thực đang lạm dụng công nghệ AI và gây ảnh hưởng xấu. Nhà văn nổi tiếng Nina Jankowicz đã nói rằng DeepNude có ảnh hưởng rất lớn đến phụ nữ trên toàn thế giới, đặc biệt là ở những quốc gia có xã hội bảo thủ như Nga. Nếu những bức ảnh khỏa thân sai sự thật được công bố công khai, nạn nhân có thể bị mất việc làm hoặc đối mặt với bạo lực gia đình.

Sensity cũng tuyên bố rằng những hình ảnh hoặc video khiêu dâm giả mạo này có khả năng được sử dụng như một phương tiện tống tiền và quấy rối.

Deepfake đe dọa, hoành hành

Không chỉ DeepNude, mà tất cả các phần mềm như Deepfake. Danielle Citron, giáo sư luật tại Đại học Boston đã nói: “Deepfake đã trở thành một vũ khí lợi hại chống lại phụ nữ”.

Công nghệ cốt lõi của phần mềm giả mạo sâu sắc Deepfake là mạng lưới GAN. GAN tạo ra hình ảnh, video hoặc giọng nói giả bằng công nghệ AI.

Kể từ năm 2017, khi Deepfake lần đầu tiên được sử dụng để làm video khiêu dâm về nhân vật Wonder Woman's Sea Incident, mạng xã hội đã tràn ngập những video như vậy.

Theo thống kê, video khiêu dâm chiếm 96% tổng số video do Deepfake tạo ra. Với sự nâng cấp liên tục của công nghệ, độ trung thực của Deepfake đã đạt đến mức không thể phân biệt bằng mắt thường, và nó cũng bắt đầu được ứng dụng vào chính trị. Những video thay đổi khuôn mặt giả của các chính trị gia nổi tiếng như Donald Trump, Barack Hussein Obama, Elon Musk, ... không hề hiếm gặp trên mạng xã hội.

Theo kết quả nghiên cứu mới nhất của giáo sư Jacob Shapiro của Đại học Princeton, từ năm 2013 đến 2019, mạng xã hội đã phát động 96 chiến dịch chính trị, trong đó 93% là nội dung gốc, 86% khuếch đại nội dung và 74% là bị bóp méo thực tế. Mục đích chủ yếu là làm mất uy tín của các chính trị gia, gây hiểu lầm cho công chúng, và làm gia tăng mâu thuẫn. Để đối phó với những mối đe dọa và thách thức do phần mềm Deepfake gây ra, trong năm 2019, Facebook đã đầu tư mạnh mẽ vào việc tung ra “Thử thách phát hiện sâu Deepfake” (Deepfake Detection Challenge, DFDC). Tới năm 2020, độ chính xác của công nghệ nhận dạng phát hiện Deepfake đã đạt 82,56%. Các học viện và các nhóm công ty khác cũng đang phát triển các phương pháp phát hiện Deepfake. Tuy nhiên, mặc dù ngày càng có nhiều phương pháp phát hiện và độ chính xác cao hơn, xu hướng tạo video giả vẫn chưa bị dập tắt.

Lý do có thể là do AI ngày càng thuận tiện hơn trong việc tạo ra nội dung sai lệch, ví dụ như DeepNude chỉ cần một bức ảnh và mọi người đều có thể sử dụng nó. Và thứ hai, theo Sensity đã nói, DeepNude vẫn nằm trong vùng xám hợp pháp. Vụ án DeepNude tiếp tục - khi dịch vụ này đã sớm được rao bán và các đoạn mã DeepNude đã xuất hiện trong GitHub.

Gần một năm rưỡi sau, vào tháng 10 năm 2020, các chuyên gia an ninh mạng từ Sensity đã nói về hệ sinh thái deepfake trong telegram - các kênh, cuộc trò chuyện có những con bot có thể “lột đồ” các cô gái bằng thuật toán. DeepNude xuất hiện dưới dạng này hay dạng khác và chúng hoạt động theo nguyên tắc tương tự - chúng loại bỏ quần áo của bất kỳ bức ảnh nào. Vì vậy, để đóng được chiếc hộp Deepfake Pandora cần có sự ràng buộc về thể chế và đạo đức của con người.

Mới đây, theo điều tra, phần mềm tạo ảnh khiêu dâm này đã xuất hiện trở lại trong ứng dụng nhắn tin tức thời-Telegram. Phần mềm này đã phát hành công khai khoảng 104.852 hình ảnh khiêu dâm trên nền tảng TeleGram , nhiều dữ liệu gồm các hình ảnh được chia sẻ công khai. Quan trọng hơn, 70% những bức hình này đều là của những người phụ nữ có thật trên mạng xã hội, thậm chí là trẻ vị thành niên. Nói cách khác, những bức ảnh tự chụp hàng ngày được chia sẻ trên các phương tiện truyền thông xã hội như Facebook, Tiktok, .v.v.v có khả năng được sử dụng để tạo ra những bức ảnh không đứng đắn này.

DeepNude đang để mắt đến "những người bạn có thể biết"

Theo một cuộc điều tra này đến từ công ty an ninh mạng Sensity có trụ sở tại Amsterdam, trong chiến dịch "tình báo về mối đe dọa trực quan", đặc biệt là việc phổ biến các video giả . Cuộc điều tra của họ cho thấy tính đến cuối tháng 7, tất cả bảy kênh chính trên nền tảng Telegram đều đang sử dụng phần mềm DeepNude.

Phần mềm Deepnude thu hút 103.585 người dùng trên toàn thế giới, trong đó kênh có nhiều người dùng nhất là 45.615. Hầu hết những người dùng này tập trung ở Nga và các khu vực lân cận của Đông Âu. Có thể có ba lý do chính dẫn đến sự bùng nổ của phần mềm này.

Quá trình tạo ảnh nude rất dễ dàng chỉ bằng một cú nhấp chuột

- Thứ hai là nó miễn phí cho tất cả mọi người. Tuy nhiên, nó cũng có mô hình tạo ra lợi nhuận. Những bức ảnh khỏa thân mà người dùng không trả tiền có được sẽ bị gắn nhãn hình mờ watermark hoặc chỉ bị lộ một phần. Người dùng có thể trả 1,28 đô la Mỹ để có được những bức ảnh không có hình mờ, nhưng sự cho phép chỉ giới hạn ở 100 bức ảnh trong bảy ngày.

- Thứ ba là lấy ảnh khỏa thân của những người thân quen. Không có gì lạ khi Deepfake giả mạo các video khiêu dâm, chủ yếu nhắm vào những người nổi tiếng. Tuy nhiên, theo một cuộc khảo sát dư luận, phần lớn người dùng quan tâm đến "những người phụ nữ mà họ biết ngoài đời" hơn, chiếm 63%.

Với các lý do như vậy, bất kỳ người dùng nào của DeepNude cũng có thể tạo ảnh khỏa thân với bất kỳ ảnh nào. Theo dữ liệu công khai trên nền tảng TeleGram, nhiều phụ nữ trong ảnh là nhân viên văn phòng và sinh viên đại học. Những bức ảnh đều là ảnh tự chụp từ các nền tảng như TikTok, Instagram và Facebook. Một điểm cần lưu ý là phần mềm này chỉ nhằm và các bức ảnh về phụ nữ. Nếu bạn tải lên một bức ảnh nam hoặc bất kỳ bức ảnh vô tri vô giác nào khác, hệ thống sẽ tự động được thay thế bằng cơ thể của phụ nữ và được thay thế bởi các bộ phận tương ứng.

Theo nhóm trưởng Giorgio Patrini của Sensity cho biết hơn 680.000 phụ nữ đã bị làm giả ảnh khiêu dâm và tải lên các nền tảng truyền thông công cộng trong những trường hợp không xác định. Dữ liệu điều tra liên quan đã được tiết lộ cho công chúng, và các cơ quan thực thi pháp luật liên quan cũng đã mở một cuộc điều tra. Cho đến nay, Telegram vẫn chưa đưa ra câu trả lời công khai về lý do tại sao phần mềm khiêu dâm lại được phép xuất hiện trên nền tảng của họ.

Cũng trong các cuộc khảo sát của Sensity, ngoài Telegram, nền tảng mạng xã hội khác của Nga là VK cũng đã phát hiện ra DeepNude , thậm chí còn bắt đầu quảng cáo phần mềm này một cách công khai. Tuy nhiên, ngay sau khi sự việc lộ ra, người có trách nhiệm liên quan đã lập tức phản hồi và phủ nhận tuyên bố này. Đồng thời, ông nhấn mạnh : " VK không chấp nhận sự hiện diện của nội dung hoặc liên kết như vậy trên nền tảng và cũng sẽ ngăn cản cộng đồng phân phối chúng. Ngoài ra, các cộng đồng hoặc liên kết như vậy không được quảng cáo bằng công cụ quảng cáo VK , chúng tôi cũng tiến hành kiểm tra bổ sung và ngăn chặn nội dung không phù hợp xuất hiện."

Được biết Deepnude là phần mềm giả mạo khiêu dâm , mục đích ban đầu được tạo ra vì sự tò mò và niềm đam mê công nghệ. Vào ngày 27 tháng 6 năm 2019, phần mềm DeepNude được ra mắt công khai lần đầu tiên và ngay sau đó, hệ thống đã ngừng hoạt động do lưu lượng người dùng quá nhiều. Chỉ trong vài giờ, phần mềm sử dụng AI chỉ bằng một cú nhấp chuột là có thể biến ảnh thường thành ảnh nude của phụ nữ này đã gây náo động cả trong và ngoài nước.

Các cáo buộc "xâm phạm quyền riêng tư và phân biệt giới tính" liên tục xuất hiện trên các nền tảng mạng xã hội lớn như Twitter, Reddit , Facebook.v.v.v. Chuyên gia tiên phong về AI và máy học Andrew Ng đăng dòng tweet rằng DeepNude là "một trong những ứng dụng kinh tởm nhất của trí tuệ nhân tạo."

Sau khi nhận được nhiều phản ứng của cả thế giới , người đứng sau phát triển nó, Alberto (Alberto) đã công khai trả lời:

"Thế giới vẫn chưa sẵn sàng cho DeepNude!" "Tôi không phải là một người thích tìm hiểu (tò mò). Tôi là tín đồ của công nghệ." Anh nhấn mạnh: “Tôi không quan tâm đến ảnh khỏa thân và những thứ tương tự. Một số người không muốn sử dụng chúng, vì vậy họ chỉ muốn để người khác không sử dụng chúng. Điều này thật ngu ngốc. Việc chặn và kiểm duyệt kiến thức kỹ thuật không thể ngăn chặn sự phát tán và lây lan của nó. . "

Người ta hiểu rằng nguồn cảm hứng nghiên cứu và phát triển của Alberto đến từ kỹ thuật chụp X-quang trên tạp chí. Anh rất quan tâm đến công nghệ AI, khi phát hiện ra mạng GAN có thể chỉnh sửa ảnh từ ngày sang đêm, anh nhận ra rằng sử dụng GAN cũng có thể chuyển ảnh có quần áo thành ảnh không có quần áo. Vì tò mò mà DeepNude cuối cùng đã được phát triển.

DeepNud dựa trên một phần mềm "dịch ảnh sang ảnh" mã nguồn mở có tên "pix2pix", được phát hiện lần đầu tiên vào năm 2018 bởi các nhà nghiên cứu AI tại Đại học California, Berkeley. Công nghệ cốt lõi của nó là GAN, có thể tạo ra ảnh giả bằng cách xác định hình ảnh thực. Chẳng hạn như thay đổi ảnh phong cảnh từ ngày sang đêm hoặc từ đen trắng sang đủ màu.

Nhưng dù là vì tò mò hay vì muốn tìm hiểu sự phát triển công nghệ, phần mềm này quả thực đang lạm dụng công nghệ AI và gây ảnh hưởng xấu. Nhà văn nổi tiếng Nina Jankowicz đã nói rằng DeepNude có ảnh hưởng rất lớn đến phụ nữ trên toàn thế giới, đặc biệt là ở những quốc gia có xã hội bảo thủ như Nga. Nếu những bức ảnh khỏa thân sai sự thật được công bố công khai, nạn nhân có thể bị mất việc làm hoặc đối mặt với bạo lực gia đình.

Sensity cũng tuyên bố rằng những hình ảnh hoặc video khiêu dâm giả mạo này có khả năng được sử dụng như một phương tiện tống tiền và quấy rối.

Deepfake đe dọa, hoành hành

Không chỉ DeepNude, mà tất cả các phần mềm như Deepfake. Danielle Citron, giáo sư luật tại Đại học Boston đã nói: “Deepfake đã trở thành một vũ khí lợi hại chống lại phụ nữ”.

Công nghệ cốt lõi của phần mềm giả mạo sâu sắc Deepfake là mạng lưới GAN. GAN tạo ra hình ảnh, video hoặc giọng nói giả bằng công nghệ AI.

Kể từ năm 2017, khi Deepfake lần đầu tiên được sử dụng để làm video khiêu dâm về nhân vật Wonder Woman's Sea Incident, mạng xã hội đã tràn ngập những video như vậy.

Theo thống kê, video khiêu dâm chiếm 96% tổng số video do Deepfake tạo ra. Với sự nâng cấp liên tục của công nghệ, độ trung thực của Deepfake đã đạt đến mức không thể phân biệt bằng mắt thường, và nó cũng bắt đầu được ứng dụng vào chính trị. Những video thay đổi khuôn mặt giả của các chính trị gia nổi tiếng như Donald Trump, Barack Hussein Obama, Elon Musk, ... không hề hiếm gặp trên mạng xã hội.

Theo kết quả nghiên cứu mới nhất của giáo sư Jacob Shapiro của Đại học Princeton, từ năm 2013 đến 2019, mạng xã hội đã phát động 96 chiến dịch chính trị, trong đó 93% là nội dung gốc, 86% khuếch đại nội dung và 74% là bị bóp méo thực tế. Mục đích chủ yếu là làm mất uy tín của các chính trị gia, gây hiểu lầm cho công chúng, và làm gia tăng mâu thuẫn. Để đối phó với những mối đe dọa và thách thức do phần mềm Deepfake gây ra, trong năm 2019, Facebook đã đầu tư mạnh mẽ vào việc tung ra “Thử thách phát hiện sâu Deepfake” (Deepfake Detection Challenge, DFDC). Tới năm 2020, độ chính xác của công nghệ nhận dạng phát hiện Deepfake đã đạt 82,56%. Các học viện và các nhóm công ty khác cũng đang phát triển các phương pháp phát hiện Deepfake. Tuy nhiên, mặc dù ngày càng có nhiều phương pháp phát hiện và độ chính xác cao hơn, xu hướng tạo video giả vẫn chưa bị dập tắt.

Lý do có thể là do AI ngày càng thuận tiện hơn trong việc tạo ra nội dung sai lệch, ví dụ như DeepNude chỉ cần một bức ảnh và mọi người đều có thể sử dụng nó. Và thứ hai, theo Sensity đã nói, DeepNude vẫn nằm trong vùng xám hợp pháp. Vụ án DeepNude tiếp tục - khi dịch vụ này đã sớm được rao bán và các đoạn mã DeepNude đã xuất hiện trong GitHub.

Gần một năm rưỡi sau, vào tháng 10 năm 2020, các chuyên gia an ninh mạng từ Sensity đã nói về hệ sinh thái deepfake trong telegram - các kênh, cuộc trò chuyện có những con bot có thể “lột đồ” các cô gái bằng thuật toán. DeepNude xuất hiện dưới dạng này hay dạng khác và chúng hoạt động theo nguyên tắc tương tự - chúng loại bỏ quần áo của bất kỳ bức ảnh nào. Vì vậy, để đóng được chiếc hộp Deepfake Pandora cần có sự ràng buộc về thể chế và đạo đức của con người.