Vn-Z.vn Ngày 10 tháng 08 năm 2022, trước sự phát triển của công nghệ AI, đã có các tình huống giả mạo người quen, người nổi tiếng để thực hiện các cuộc gọi video áp dụng công nghệ Deep Fake để lừa đảo. Công nghệ giả mạo AI này dễ dàng đánh lừa người khác ngay cả với người am hiểu về công nghệ.

Kẻ xấu có thể tiến hành ghép hình ảnh khuôn mặt vào video dựa trên AI bằng DeepFake thật đến mức người ta khó có thể phân biệt bằng mắt thường. Chúng có thể tiến hành các cuộc gọi video để lừa đảo, gian lận ... nếu người dùng không cảnh giác sẽ rất dễ bị lừa.

Hôm nay Vn-Z team sẽ hướng đẫn bạn đọc cách phòng chống Deep Fake trước nguy cơ lừa đảo qua mạng ngày càng tinh vi.

Một trong những biện pháp đơn giản nhất là yêu cầu người gọi video quay sang trái góc 90 độ. Hiện tại công nghệ DeepFake sẽ khó tái tạo khuôn mặt giả khi chủ thể hoàn toàn nghiêng sang một bên (quay 90 °), lúc này độ chân thực sẽ giảm mạnh.

Tại sao khi khuôn mặt quay sang một góc 90 độ sẽ giúp chúng ta phân biệt được khuôn mặt giả bằng DeepFake . Điều này là do hầu hết các thuật toán căn chỉnh khuôn mặt dựa trên 2D chỉ nắm bắt được 50% -60% các điểm đặc trưng ở chế độ xem phụ so với chế độ xem chính.

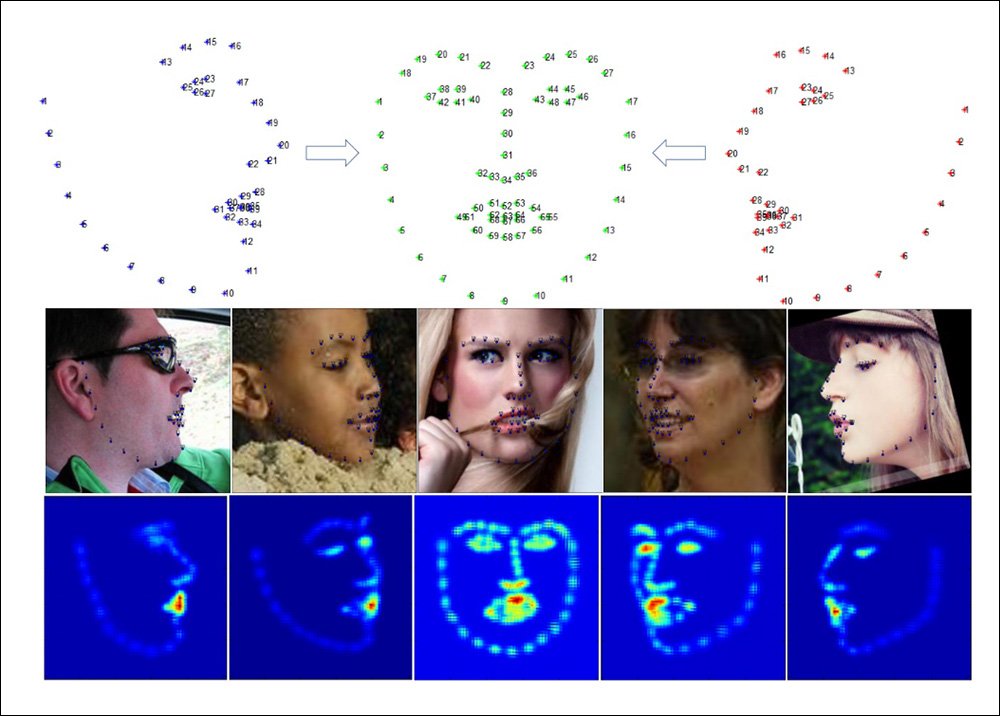

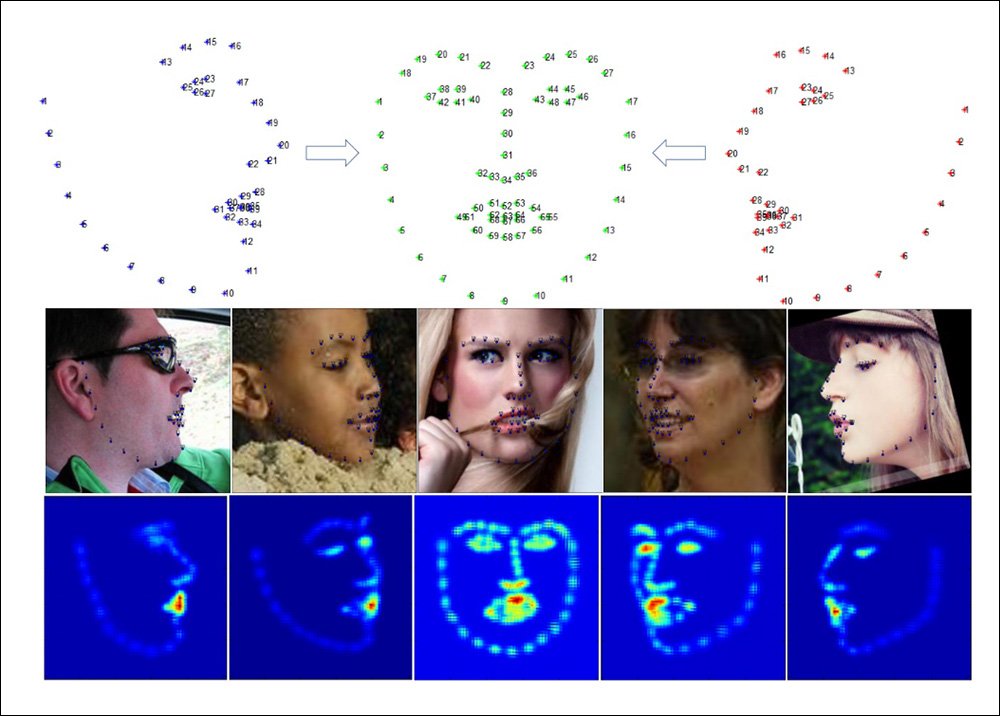

Bằng cách phân tích thuật toán căn chỉnh khuôn mặt ở mô hình Joint Multi-view Face Alignment in the Wild và Multi-view Hourglass làm ví dụ ta sẽ thấy sự khác biệt.

Hai mô hình trên AI được đào tạo bằng cách xác định các điểm đặc trưng từ các khuôn mặt dưới dạng dữ liệu học. Qua hình ảnh dưới đây, 68 điểm đặc trưng được xác định khi căn chỉnh phía trước được thực hiện, trong khi chỉ có 39 điểm đặc trưng được xác định khi căn chỉnh quay sang bên được thực hiện.

Chế độ xem khuôn mặt góc 90 độ ẩn 50% điểm đặc trưng, điều này không chỉ cản trở việc nhận dạng mà còn ảnh hưởng đến độ chính xác của quá trình đào tạo và tổng hợp khuôn mặt sau đó.

Theo một số chuyên gia tìm hiểu về DeepFake cho biết . Thuật toán AI xử lý khuôn mặt ở góc 90 độ ( mặt bên) quả thực là một vấn đề lớn. Mạng lưới căn chỉnh trên khuôn mặt hoạt động rất tốt cho mặt trước, nhưng không tốt cho hai bên. Các thuật toán này có những hạn chế cơ bản . Thuật toán tái tạo khá tốt khuôn mặt nếu bạn chỉ che một phần khuôn mặt của mình, cơ chế căn chỉnh hoạt động tốt và rất mạnh trong trường hợp này, nhưng khi bạn quay sang phải hoặc sang trái , hơn một nửa số điểm đặc trưng bị mất.

Tuy nhiên Deepfake cũng có những bước tiến trong việc huấn luyện AI. Để đạt được hiệu ứng thực tế hơn, Deepfake AI cần phải có một lượng lớn dữ liệu và cần được đào tạo khi chủ thể thay đổi diện mạo.

Người ta đã huấn luyện AI thay thế khuôn mặt của Jerry Seinfeld vào một cảnh trong bộ phim Pulp Fiction (1994) bằng cách đào tạo AI bằng một lượng lớn dữ liệu. Lúc này chúng ta khó có thể nhìn thấy những sai sót trong ảnh hồ sơ thu được bằng mắt thường. "Seinfeld" deepfake có tới 66 giờ cảnh quay có thể sử dụng cho khóa đào tạo này.

Như vậy ngoại trừ diễn viên điện ảnh hoặc những người nổi tiếng vì có quá nhiều thông tin dữ liệu cho AI khai thác, những người bình thường chúng ta có rất ít dữ liệu hình ảnh, khi chụp ảnh và quay phim ít người ghi lại được những bức ảnh lộ hoàn toàn 90 °. Do đó, khuôn mặt được giả mạo bởi DeepFake rất dễ lộ khuyết điểm nếu quay các góc 90độ.

Khuôn mặt giả cũng có thể được nhận dạng bằng cách đưa tay trước mặt

Để có thể kiểm tra phía bên kia có sử dụng DeepFake để giả mạo trong những cuộc gọi video hay không, ngoài việc kiểm tra bằng cách yêu cầu họ quay mặt sang bên các góc 90 độ, thì còn có một phương pháp nhỏ đó là yêu cầu họ đưa tay trước mặt.

YouTuber Druuzil Tech and Games gián đoạn kỹ thuật số khi mạo danh Scarlett Johansson và Patrick Stewart. Nguồn: và

Khi đưa tay lên khuôn mặt , Youtuber Sister Widow và Giáo sư X, sự chồng chéo của bàn tay và khuôn mặt khiến AI bị nhầm lẫn. Thuận toán DeepFakes trong thời gian thực tất cả đều phải đối mặt với vấn đề chồng chất các vết tắc thật lên hình ảnh khuôn mặt không thật, thao tác này thường được gọi là "tạo mặt nạ" hoặc "xóa nền". Tuy nhiên, thường có nhiều tác động gây nhầm lẫn ảnh hưởng đến quá trình “ánh xạ”, ví dụ như tác động của bàn tay với các đặc điểm trên khuôn mặt sẽ gây “rắc rối” cho khuôn mẫu từ đó AI khó thực hiện quá trình “lập bản đồ”.

Nếu bạn yêu cầu đối phương Lắc tay trước mặt, sự chuyển động nhanh của bàn tay sẽ gây khó khăn rất lớn trong việc bắt khuôn mặt, gây ra nhiều độ trễ và ảnh hưởng đến chất lượng của lớp phủ mặt nạ.

Các phương pháp lừa đảo bằng việc hoán đổi khuôn mặt không còn xa lạ . Trên mạng đã có những tình huống kẻ tình nghi sử dụng công nghệ hoán đổi khuôn mặt DeepFake thực hiện các cuộc phỏng vấn từ xa vào các vị trí IT , kẻ tình nghi đang cố gắng xâm nhập vào các công ty để truy cập vào hệ thống dữ liệu tài chính hoặc khách hàng của họ, cũng như dữ liệu CNTT của các công ty mục tiêu.

FBI đã gửi cảnh báo đến Trung tâm Khiếu nại Tội phạm Internet, cho biết họ đã nhận được rất nhiều lời phàn nàn của những kẻ tình nghi dụng thông tin bị đánh cắp ,các video , giọng nói để tiến hành giả mạo cho các mục đích xin việc từ xa, lừa đảo.v.v.v... một số nghi phạm dùng Deepfake hoạt động thông qua nhiều lớp vỏ bọc với nhiều công ty khiến việc xác định chúng trở nên khó khăn hơn.

Hiện tại trên các diễn đàn hacker , tình trạng mua bán dữ liệu người dùng đang diễn ra rất phức tạp. Các dữ liệu nhạy cảm như KYC (Know Your Customer),eKYC - dữ liệu để xác minh thông tin người dùng bao gồm cả video khuôn mặt, ghi âm giọng nói,.v.v.v là nguồn dữ liệu phong phú để Deepfake có thể khai tác trong việc huấn luyện AI phục vụ cho các mục đích xấu của hacker.

vn-z.vn

vn-z.vn

vn-z.vn

vn-z.vn

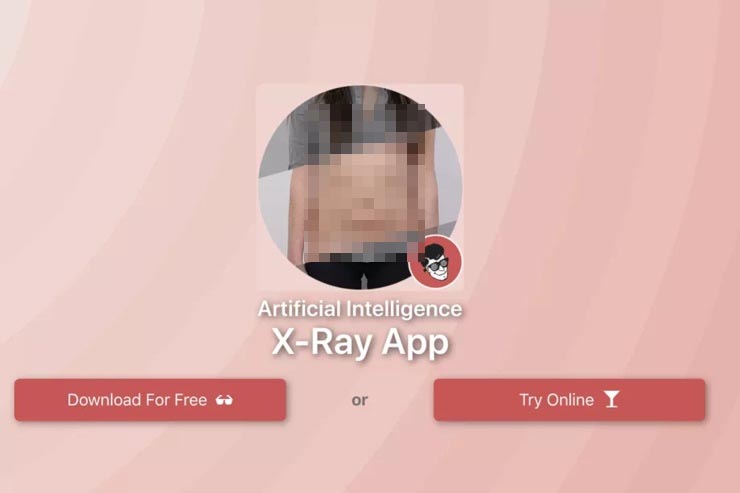

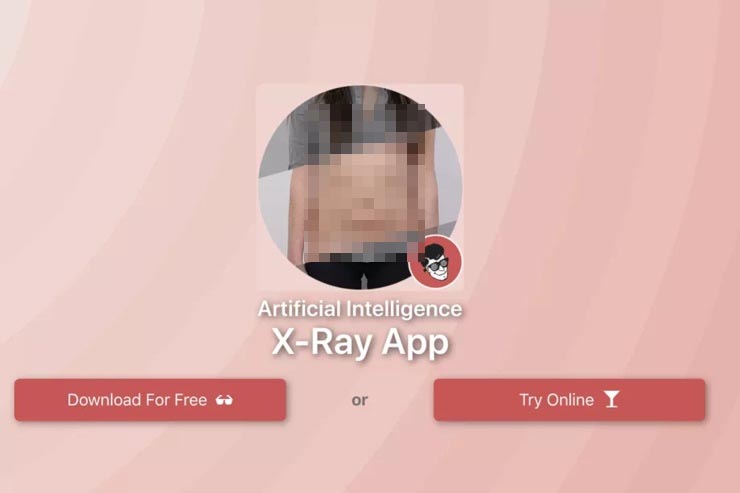

Trong bài viết này team Vn-Z từng đề cập những mặt trái trong công nghệ AI của Deepfake, Deepnude. Những video khiêu dâm chiếm 96% tổng số video do Deepfake tạo ra. Với sự nâng cấp liên tục của công nghệ, độ trung thực của Deepfake đã đạt đến mức không thể phân biệt bằng mắt thường, và nó cũng bắt đầu được ứng dụng vào nhiều mục tiêu lừa đảo nguy hiểm hơn .

vn-z.vn

vn-z.vn

Như vậy có thể thấy các hình thức tấn công, lừa đảo trên không gian mạng rất phức tạp và tinh vi . Người dùng cần hết sức cảnh giác và phải trang bị cho mình nhiều kiến thức tự bảo vệ mình trước thời đại phát trển của công nghệ như ngày nay.

Cập nhật ngày 27 tháng 03 năm 2023. Đã xuất hiện hành vi ghép mặt, video , giọng nói ... bằng công nghệ Deepfake AI giống hệt người thân, quen để lừa đảo tại Việt Nam

Theo đó, chị Th. đang làm việc thì nhận được tin nhắn của bạn thân qua Facebook hỏi mượn 20 triệu đồng để đủ tiền đáo hạn ngân hàng. Nghi ngờ Facebook người bạn bị chiếm tài khoản, lừa đảo nên chị Th. đã gọi video để kiểm chứng.

Phía bên kia bắt máy, mở video cho chị Th. thấy mặt bạn nhưng hình ảnh mờ, chập chờn và nói đang cần tiền gấp. Khi chị Th. hỏi sao hình ảnh mờ thì bên kia trả lời "đang vùng sóng yếu". Chị Th. tin tưởng, chuyển 20 triệu đồng vào số tài khoản theo yêu cầu.

Sau khi chuyển tiền được 30 phút, chị Th. dùng điện thoại gọi cho cô bạn hỏi thăm thì mới biết mình đã bị lừa.

Hình ảnh Công an Tuyên Quang cung cấp.

Chiều 25/3, Công an tỉnh Tuyên Quang cho biết, trên không gian mạng đã xuất hiện phương thức lừa đảo chiếm đoạt tài sản rất tinh vi, bằng công nghệ ứng dụng trí tuệ nhân tạo (AI).

Cụ thể, chúng sử dụng công nghệ Deepfake AI, tạo ra các sản phẩm công nghệ âm thanh, hình ảnh và video làm giả người ngoài đời thực với độ chính xác rất cao.

Khi chúng thực hiện cuộc gọi video để giả làm người thân vay tiền, giả làm con cái đang du học nước ngoài gọi điện cho bố mẹ nhờ chuyển tiền đóng học phí hay có thể tạo ra những tình huống khẩn cấp như người thân bị tai nạn cần tiền gấp để cấp cứu…

Để thực hiện được hình thức lừa đảo này, các đối tượng tìm kiếm, thu thập thông tin cá nhân, hình ảnh, video có giọng nói được đăng tải công khai trên các tài khoản mạng xã hội… rồi sử dụng công nghệ Deepfake để tạo sẵn những video rất khó phân biệt thật - giả, có hình ảnh, giọng nói của cá nhân đó để phục vụ cho kịch bản lừa đảo.

Đặc điểm chung của những cuộc gọi video như vậy thường có âm thanh, hình ảnh không rõ nét, tín hiệu chập chờn giống như cuộc gọi video trong khu vực phủ sóng di động hoặc wifi yếu để nạn nhân khó phân biệt thật, giả.

Nếu nạn nhân cẩn thận gọi video để kiểm tra thì chúng sẽ không nhận cuộc gọi hoặc sử dụng phần mềm cắt ghép hình ảnh, video để đánh lừa.

Từ những căn cứ nêu trên, Công an tỉnh Tuyên Quang khuyến cáo và đề nghị mọi người nâng cao cảnh giác, khi nhận bất kỳ tin nhắn, cuộc gọi video với nội dung vay, mượn tiền qua các ứng dụng mạng xã hội.

Cần bình tĩnh, sau đó gọi điện thoại trực tiếp cho người thân để xác minh (không gọi qua các ứng dụng như Zalo, Messenger, Viber, Telegram…).

Trường hợp nghi vấn đối tượng giả mạo người thân trên mạng xã hội để lừa đảo, chiếm đoạt tài sản, cần báo ngay cho cơ quan công an gần nhất để được hỗ trợ, xử lý kịp thời.

(Nguồn: Vietnamnet)

Kẻ xấu có thể tiến hành ghép hình ảnh khuôn mặt vào video dựa trên AI bằng DeepFake thật đến mức người ta khó có thể phân biệt bằng mắt thường. Chúng có thể tiến hành các cuộc gọi video để lừa đảo, gian lận ... nếu người dùng không cảnh giác sẽ rất dễ bị lừa.

Hôm nay Vn-Z team sẽ hướng đẫn bạn đọc cách phòng chống Deep Fake trước nguy cơ lừa đảo qua mạng ngày càng tinh vi.

Một trong những biện pháp đơn giản nhất là yêu cầu người gọi video quay sang trái góc 90 độ. Hiện tại công nghệ DeepFake sẽ khó tái tạo khuôn mặt giả khi chủ thể hoàn toàn nghiêng sang một bên (quay 90 °), lúc này độ chân thực sẽ giảm mạnh.

Tại sao khi khuôn mặt quay sang một góc 90 độ sẽ giúp chúng ta phân biệt được khuôn mặt giả bằng DeepFake . Điều này là do hầu hết các thuật toán căn chỉnh khuôn mặt dựa trên 2D chỉ nắm bắt được 50% -60% các điểm đặc trưng ở chế độ xem phụ so với chế độ xem chính.

Bằng cách phân tích thuật toán căn chỉnh khuôn mặt ở mô hình Joint Multi-view Face Alignment in the Wild và Multi-view Hourglass làm ví dụ ta sẽ thấy sự khác biệt.

Hai mô hình trên AI được đào tạo bằng cách xác định các điểm đặc trưng từ các khuôn mặt dưới dạng dữ liệu học. Qua hình ảnh dưới đây, 68 điểm đặc trưng được xác định khi căn chỉnh phía trước được thực hiện, trong khi chỉ có 39 điểm đặc trưng được xác định khi căn chỉnh quay sang bên được thực hiện.

Chế độ xem khuôn mặt góc 90 độ ẩn 50% điểm đặc trưng, điều này không chỉ cản trở việc nhận dạng mà còn ảnh hưởng đến độ chính xác của quá trình đào tạo và tổng hợp khuôn mặt sau đó.

Tuy nhiên Deepfake cũng có những bước tiến trong việc huấn luyện AI. Để đạt được hiệu ứng thực tế hơn, Deepfake AI cần phải có một lượng lớn dữ liệu và cần được đào tạo khi chủ thể thay đổi diện mạo.

Như vậy ngoại trừ diễn viên điện ảnh hoặc những người nổi tiếng vì có quá nhiều thông tin dữ liệu cho AI khai thác, những người bình thường chúng ta có rất ít dữ liệu hình ảnh, khi chụp ảnh và quay phim ít người ghi lại được những bức ảnh lộ hoàn toàn 90 °. Do đó, khuôn mặt được giả mạo bởi DeepFake rất dễ lộ khuyết điểm nếu quay các góc 90độ.

Khuôn mặt giả cũng có thể được nhận dạng bằng cách đưa tay trước mặt

Để có thể kiểm tra phía bên kia có sử dụng DeepFake để giả mạo trong những cuộc gọi video hay không, ngoài việc kiểm tra bằng cách yêu cầu họ quay mặt sang bên các góc 90 độ, thì còn có một phương pháp nhỏ đó là yêu cầu họ đưa tay trước mặt.

YouTuber Druuzil Tech and Games gián đoạn kỹ thuật số khi mạo danh Scarlett Johansson và Patrick Stewart. Nguồn: và

Khi đưa tay lên khuôn mặt , Youtuber Sister Widow và Giáo sư X, sự chồng chéo của bàn tay và khuôn mặt khiến AI bị nhầm lẫn. Thuận toán DeepFakes trong thời gian thực tất cả đều phải đối mặt với vấn đề chồng chất các vết tắc thật lên hình ảnh khuôn mặt không thật, thao tác này thường được gọi là "tạo mặt nạ" hoặc "xóa nền". Tuy nhiên, thường có nhiều tác động gây nhầm lẫn ảnh hưởng đến quá trình “ánh xạ”, ví dụ như tác động của bàn tay với các đặc điểm trên khuôn mặt sẽ gây “rắc rối” cho khuôn mẫu từ đó AI khó thực hiện quá trình “lập bản đồ”.

Nếu bạn yêu cầu đối phương Lắc tay trước mặt, sự chuyển động nhanh của bàn tay sẽ gây khó khăn rất lớn trong việc bắt khuôn mặt, gây ra nhiều độ trễ và ảnh hưởng đến chất lượng của lớp phủ mặt nạ.

Các phương pháp lừa đảo bằng việc hoán đổi khuôn mặt không còn xa lạ . Trên mạng đã có những tình huống kẻ tình nghi sử dụng công nghệ hoán đổi khuôn mặt DeepFake thực hiện các cuộc phỏng vấn từ xa vào các vị trí IT , kẻ tình nghi đang cố gắng xâm nhập vào các công ty để truy cập vào hệ thống dữ liệu tài chính hoặc khách hàng của họ, cũng như dữ liệu CNTT của các công ty mục tiêu.

FBI đã gửi cảnh báo đến Trung tâm Khiếu nại Tội phạm Internet, cho biết họ đã nhận được rất nhiều lời phàn nàn của những kẻ tình nghi dụng thông tin bị đánh cắp ,các video , giọng nói để tiến hành giả mạo cho các mục đích xin việc từ xa, lừa đảo.v.v.v... một số nghi phạm dùng Deepfake hoạt động thông qua nhiều lớp vỏ bọc với nhiều công ty khiến việc xác định chúng trở nên khó khăn hơn.

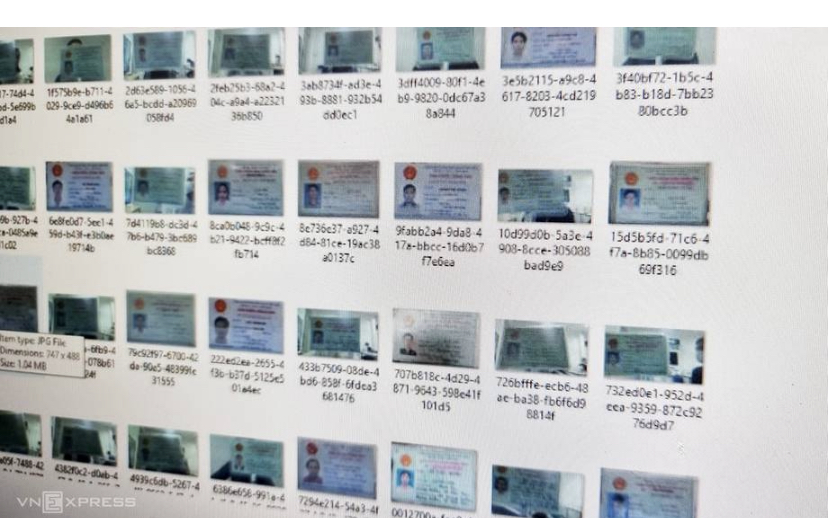

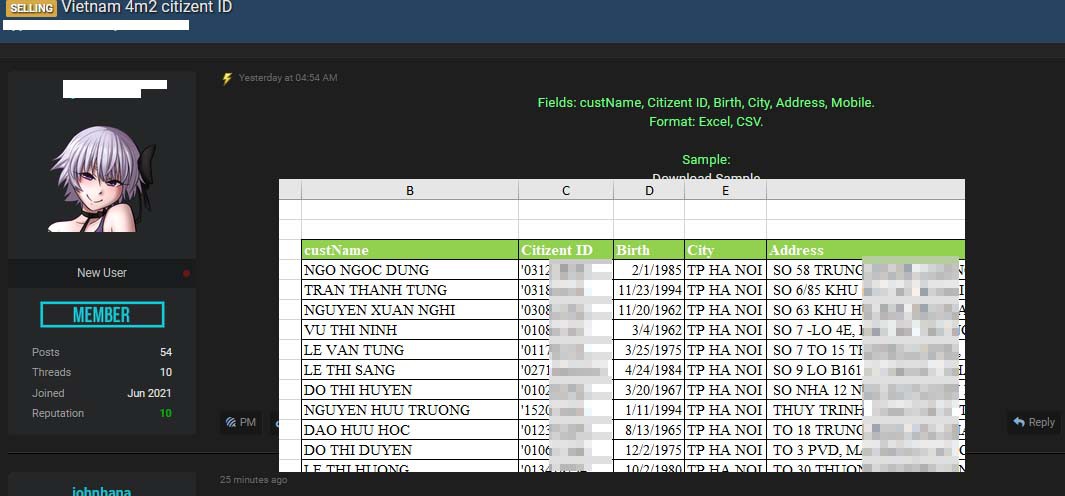

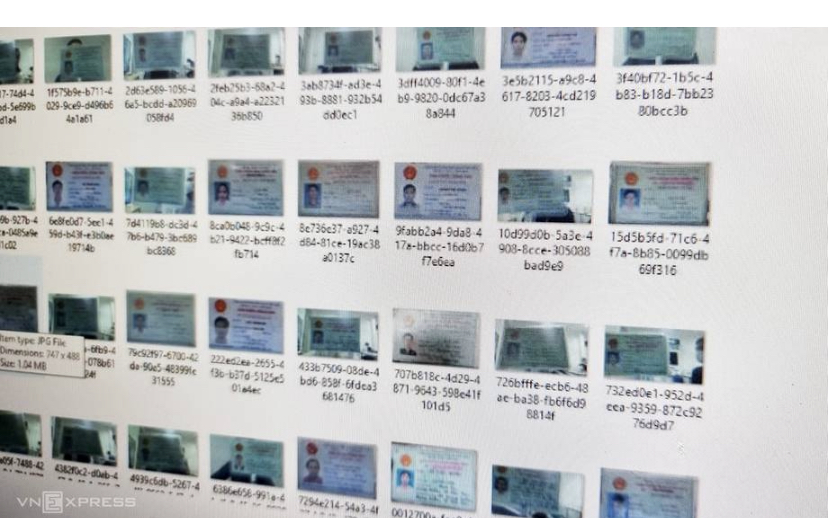

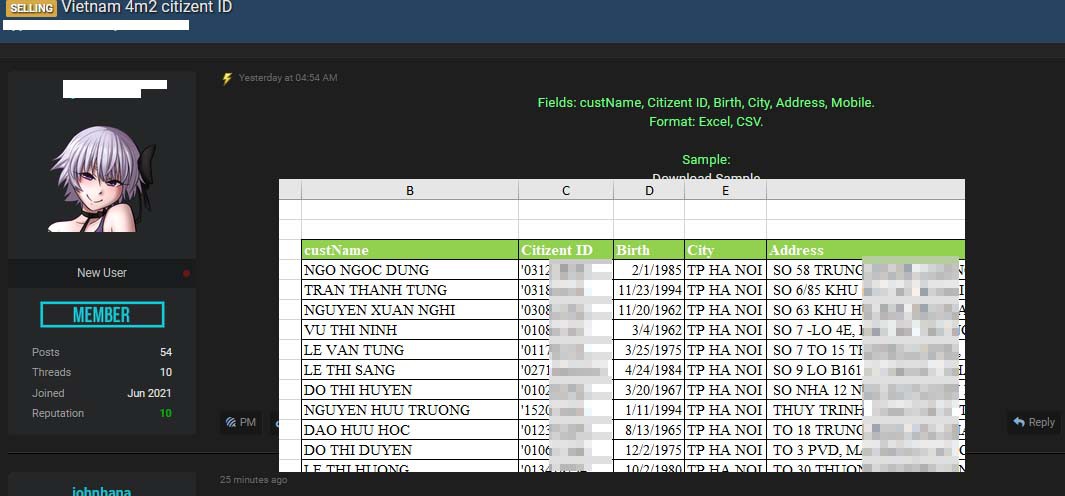

Hiện tại trên các diễn đàn hacker , tình trạng mua bán dữ liệu người dùng đang diễn ra rất phức tạp. Các dữ liệu nhạy cảm như KYC (Know Your Customer),eKYC - dữ liệu để xác minh thông tin người dùng bao gồm cả video khuôn mặt, ghi âm giọng nói,.v.v.v là nguồn dữ liệu phong phú để Deepfake có thể khai tác trong việc huấn luyện AI phục vụ cho các mục đích xấu của hacker.

Hàng nghìn dữ liệu KYC (Know Your Customer ) Selfie, CMND người Việt bị rao bán

Vn-Z.vn Ngày 16 tháng 05 năm 2021, Hàng nghìn thông tin hình ảnh chụp chứng minh nhân dân , sổ hộ khẩu , selfie, ... người Việt Nam bị rao bán trên mạng , dữ liệu được rao bán có dung lượng tới 100 GB dữ liệu KYC (Know Your Customer ) Selfie, CMND người Việt VN-Z team tìm hiểu dữ liệu...

Hàng triệu dữ liệu số CMND thông tin người Việt lại bị rao bán

Vn-Z.vn Ngày 08 tháng 01 năm 2022, vấn đề thông tin cá nhân bị rao bán trong thời gian gần đây đang nhận được nhiều sự quan tâm của cộng đồng mạng. Mới đây cũng trên diễn đàn của hacker , dữ liệu người Việt tiếp tục bị rao bán. Thông tin bị rao bán bao gồm các Họ tên, số CMND , căn cước...

Trong bài viết này team Vn-Z từng đề cập những mặt trái trong công nghệ AI của Deepfake, Deepnude. Những video khiêu dâm chiếm 96% tổng số video do Deepfake tạo ra. Với sự nâng cấp liên tục của công nghệ, độ trung thực của Deepfake đã đạt đến mức không thể phân biệt bằng mắt thường, và nó cũng bắt đầu được ứng dụng vào nhiều mục tiêu lừa đảo nguy hiểm hơn .

Mặt trái của AI Deep fake, Deepnude bị phát hiện tiếp tục đánh cắp và tạo ra những bức ảnh không đứng đắn

(VN-Z.vn) Ngày 21 tháng 10 năm 2020, Mình nghe ở đâu đó có câu nói " Công nghệ là vô tội, thiện ác ở trong lòng người." Mặt trái của AI Deep fake đánh cắp "ảnh tự sướng và tạo ra những bức ảnh không đứng đắn. Bạn còn nhớ DeepNude "một cú nhấp chuột AI sẽ lột đồ" chứ? Vào tháng 6 năm 2019, phần...

Như vậy có thể thấy các hình thức tấn công, lừa đảo trên không gian mạng rất phức tạp và tinh vi . Người dùng cần hết sức cảnh giác và phải trang bị cho mình nhiều kiến thức tự bảo vệ mình trước thời đại phát trển của công nghệ như ngày nay.

Cập nhật ngày 27 tháng 03 năm 2023. Đã xuất hiện hành vi ghép mặt, video , giọng nói ... bằng công nghệ Deepfake AI giống hệt người thân, quen để lừa đảo tại Việt Nam

Các đối tượng sử dụng công nghệ Deepfake AI, tạo ra các sản phẩm công nghệ âm thanh, hình ảnh và video với độ chính xác rất cao để lừa đảo.

Mới đây, chị Nguyễn Thị Th. (ngụ phường Linh Tây, TP Thủ Đức, TP.HCM) bị lừa mất 20 triệu đồng với hình thức gọi video qua Facebook.Theo đó, chị Th. đang làm việc thì nhận được tin nhắn của bạn thân qua Facebook hỏi mượn 20 triệu đồng để đủ tiền đáo hạn ngân hàng. Nghi ngờ Facebook người bạn bị chiếm tài khoản, lừa đảo nên chị Th. đã gọi video để kiểm chứng.

Phía bên kia bắt máy, mở video cho chị Th. thấy mặt bạn nhưng hình ảnh mờ, chập chờn và nói đang cần tiền gấp. Khi chị Th. hỏi sao hình ảnh mờ thì bên kia trả lời "đang vùng sóng yếu". Chị Th. tin tưởng, chuyển 20 triệu đồng vào số tài khoản theo yêu cầu.

Sau khi chuyển tiền được 30 phút, chị Th. dùng điện thoại gọi cho cô bạn hỏi thăm thì mới biết mình đã bị lừa.

Hình ảnh Công an Tuyên Quang cung cấp.

Chiều 25/3, Công an tỉnh Tuyên Quang cho biết, trên không gian mạng đã xuất hiện phương thức lừa đảo chiếm đoạt tài sản rất tinh vi, bằng công nghệ ứng dụng trí tuệ nhân tạo (AI).

Cụ thể, chúng sử dụng công nghệ Deepfake AI, tạo ra các sản phẩm công nghệ âm thanh, hình ảnh và video làm giả người ngoài đời thực với độ chính xác rất cao.

Khi chúng thực hiện cuộc gọi video để giả làm người thân vay tiền, giả làm con cái đang du học nước ngoài gọi điện cho bố mẹ nhờ chuyển tiền đóng học phí hay có thể tạo ra những tình huống khẩn cấp như người thân bị tai nạn cần tiền gấp để cấp cứu…

Để thực hiện được hình thức lừa đảo này, các đối tượng tìm kiếm, thu thập thông tin cá nhân, hình ảnh, video có giọng nói được đăng tải công khai trên các tài khoản mạng xã hội… rồi sử dụng công nghệ Deepfake để tạo sẵn những video rất khó phân biệt thật - giả, có hình ảnh, giọng nói của cá nhân đó để phục vụ cho kịch bản lừa đảo.

Đặc điểm chung của những cuộc gọi video như vậy thường có âm thanh, hình ảnh không rõ nét, tín hiệu chập chờn giống như cuộc gọi video trong khu vực phủ sóng di động hoặc wifi yếu để nạn nhân khó phân biệt thật, giả.

Nếu nạn nhân cẩn thận gọi video để kiểm tra thì chúng sẽ không nhận cuộc gọi hoặc sử dụng phần mềm cắt ghép hình ảnh, video để đánh lừa.

Từ những căn cứ nêu trên, Công an tỉnh Tuyên Quang khuyến cáo và đề nghị mọi người nâng cao cảnh giác, khi nhận bất kỳ tin nhắn, cuộc gọi video với nội dung vay, mượn tiền qua các ứng dụng mạng xã hội.

Cần bình tĩnh, sau đó gọi điện thoại trực tiếp cho người thân để xác minh (không gọi qua các ứng dụng như Zalo, Messenger, Viber, Telegram…).

Trường hợp nghi vấn đối tượng giả mạo người thân trên mạng xã hội để lừa đảo, chiếm đoạt tài sản, cần báo ngay cho cơ quan công an gần nhất để được hỗ trợ, xử lý kịp thời.

(Nguồn: Vietnamnet)